谷歌已开发出了自己的定制芯片来加速其机器学习算法,这已不是什么秘密。这家公司早在2016年5月的I/O开发者大会上首次披露了名为Tensor处理单元(TPU)的那类芯片,但是它从来没有非常详细深入地介绍过这款芯片,只是表示该芯片针对公司自己的TensorFlow框架进行了优化。如今,它头一遭披露了关于这个项目的更多细节(https://drive.google.com/file/d/0Bx4hafXDDq2EMzRNcy1vSUxtcEk/view)和基准测试结果(https://cloudplatform.googleblog.com/2017/04/quantifying-the-performance-of-the-TPU-our-first-machine-learning-chip.html)。

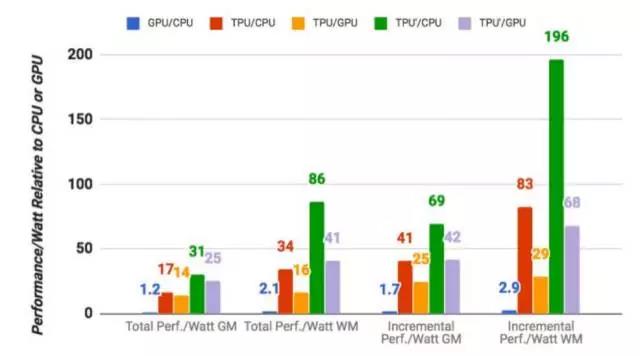

如果你是个芯片设计师,可以在谷歌的上述文章中找到关于TPU工作原理的所有具体细节。不过,这里最重要的数字是,从谷歌自己的基准测试结果来看(有必要提醒一点,这是谷歌评测自家芯片),TPU在执行谷歌的常规机器学习工作负载时,比标准的GPU/CPU组合(这里是指英特尔Haswell处理器和英伟达K80 GPU)平均要快15倍至30倍。另外由于功耗在数据中心中很重要,TPU的每秒执行万亿次运算/瓦特(TeraOps/Watt)也要高出30倍至80倍(如果将来使用速度更快的内存,那些数字可能会更高)。

顺便说一下,值得一提的是,这些数字是使用生产环境下的机器学习模型得出的,而不是首先建立模型。

谷歌还特别指出,虽然大多数架构师针对卷积神经网络(这是一种特定类型的神经网络,非常适用于图像识别)优化了芯片,但谷歌表示,那种网络在其自己的数据中心工作负载中仅占5%左右的比例,大多数的应用还是使用多层感知器(multi-layer perceptron)。

谷歌表示,它早在2006年就开始研究如何在其数据中心中使用GPU、FPGA和定制ASIC(TPU实际上就是一种ASIC)。不过当时,没有那么多的应用有望真正得益于这种特殊的硬件,因为它们所需的繁重工作负载大多数完全可以利用当时数据中心拥有的多余硬件。谷歌文章的作者写道:“这种情况在2013年发生了变化,当时我们预测,深度神经网络(DDN)有望变得非常流行起来;那样一来,我们数据中心面临的计算需求可能会翻番,如果使用传统CPU来满足这种要求,将需要非常高昂的成本。因而,我们启动了一个优先级很高的项目,迅速生产用于推理的定制ASIC(并且购买了现成的GPU用于训练)。”谷歌的研究人员表示,这方面的目的在于,“相比GPU,将性价比提高10倍。”

谷歌不太可能让TPU用在自家云的外面,但是这家公司特别指出,预计其他公司会汲取自己获得的宝贵经验,进而研制“进一步提升标准的后续芯片。”

原文来自微信公众号:云头条

本文链接:https://www.yunweipai.com/12654.html

网友评论comments