дҪңиҖ…з®Җд»Ӣпјҡ

еј ж°ёзҰҸ

еӨ§жІідә‘иҒ” иө„ж·ұзҪ‘з»ңжһ¶жһ„еёҲ

дёҖеҗҚд»ҺдәӢдј з»ҹзҪ‘з»ңе·ҘдҪңеҚҒеҮ е№ҙзҡ„иҖҒзҪ‘е·ҘпјҢд»ҺзҪ‘з»ңдә§е“Ғд»ЈзҗҶе•ҶеҲ°зі»з»ҹйӣҶжҲҗе•ҶеҶҚеҲ° CISCO еҺӮе•ҶпјҢе§Ӣз»ҲжңӘиғҪйҖғи„ұеҮәзҒ«зғӯзҡ„дёҖзәҝпјҢжңҖз»ҲиҝҳжҳҜеҸӘжҮӮзҡ„жҗ¬з –пјҢдёҚжҮӮjavaгҖҒPython зӯүй«ҳзә§жҠҖиғҪгҖӮдёәдәҶиғҪи§Јж”ҫиҮӘе·ұпјҢи§Јж”ҫжӣҙеӨҡзҡ„дёҖзәҝиҝҗз»ҙдәәе‘ҳпјҢд»Һ2016е№ҙ6жңҲејҖе§ӢеҠ е…ҘеӨ§жІідә‘иҒ”д»ҺдәӢ SDN зҪ‘з»ңзӣёе…іе·ҘдҪңпјҢдё“жіЁдәҺ SDN зҪ‘з»ңиҮӘеҠЁеҢ–иҝҗз»ҙжһ¶жһ„и®ҫи®ЎгҖӮ

еүҚиЁҖ

жҲ‘жҳҜжқҘиҮӘеӨ§жІідә‘иҒ”зҡ„еј ж°ёзҰҸпјҢд»ҠеӨ©зҡ„дёӢеҚҲеңәжҳҜеҹәзЎҖжһ¶жһ„гҖӮд№ӢеүҚдә”е…ӯе№ҙзҡ„ж—¶й—ҙпјҢжҲ‘дёҖзӣҙеңЁ Cisco еҺӮе•ҶеҒҡиҝҗз»ҙпјҢеҺ»е№ҙеҠ е…ҘеӨ§жІідә‘иҒ”еҒҡSDNзҪ‘з»ңжһ¶жһ„и®ҫи®Ўе’ҢиҮӘеҠЁеҢ–иҝҗз»ҙзі»з»ҹи®ҫи®ЎгҖӮжһ„е»әеҹәдәҺSDNзҪ‘з»ңзҡ„иҮӘеҠЁеҢ–иҝҗз»ҙзі»з»ҹиҝҷдёӘиҜқйўҳи°Ҳеҫ—жңүзӮ№ж—©пјҢSDN еңЁдёӯеӣҪеҲҡеҲҡиө·жӯҘпјҢжҳҺе№ҙе’ҢеҗҺе№ҙпјҢдјҡжңүжӣҙеӨҡдәәжҺҘи§ҰеҲ° SDN иҝҷдёӘж–°жҠҖжңҜзҡ„иҝҗз»ҙгҖӮеёҢжңӣжӣҙеӨҡзҺ°жңүзҡ„иҝҗз»ҙдәәе‘ҳеҸҜд»ҘеҸӮдёҺеҲ° SDN зҪ‘з»ңиҝҗз»ҙпјҢдҪҝдёӯеӣҪзҡ„ SDN жӣҙеҝ«зҡ„еҸ‘еұ•гҖӮ

д»ҠеӨ©еҲҶдә«д»ҘдёӢеҮ йғЁеҲҶеҶ…е®№пјҡ

- зҪ‘з»ңжҠҖжңҜжј”и®І

- дј з»ҹзҪ‘з»ңиҝҗз»ҙзҺ°зҠ¶

- SDN зҪ‘з»ңиҝҗз»ҙ

- SDN иҮӘеҠЁеҢ–иҝҗз»ҙ

- SDN иҝҗз»ҙдҪ“зі»жһ¶жһ„

1гҖҒзҪ‘з»ңжҠҖжңҜжј”иҝӣ

1.1 еҺҶеҸІеӣһйЎҫ

зҪ‘з»ңе·Із»ҸеҸ‘еұ•дәҶеҮ еҚҒе№ҙпјҢжҲ‘们иҝӣиЎҢз®ҖеҚ•жўізҗҶпјҢеҸҜд»ҘеҲҶдёәеҰӮдёӢдёүдёӘйҳ¶ж®өгҖӮ

- 第дёҖйҳ¶ж®өпјҢжҳҜд»ҺдёғеҮ е№ҙеҲ°е…«еҮ е№ҙпјҢиҝҷдёӘйҳ¶ж®өзҪ‘з»ңжӯЈеңЁеҒҡд»Җд№Ҳпјҹ1974е№ҙејҖе§ӢпјҢTCP/IP еҚҸи®®зҡ„еҸ‘еёғпјҢејҖе§ӢдәҶеҰӮдҪ•и®©зҪ‘з»ңжӣҙеӨ§иҢғеӣҙиҝһжҺҘзҡ„е·ҘдҪңгҖӮ

- 第дәҢйҳ¶ж®өпјҢд»Һ1995е№ҙејҖе§ӢеҒҡеҝ«йҖҹд»ҘеӨӘзҪ‘ж ҮеҮҶпјҢ1997е№ҙIETFжҲҗз«ӢMPLSе·ҘдҪңз»„гҖӮеңЁз¬¬дәҢйҳ¶ж®өдёӯпјҢ2005е№ҙеҜ№дәҺдёӯеӣҪзҪ‘з»ңжҳҜеҫҲе…ій”®зҡ„дёҖе№ҙпјҢиҝҷдёҖе№ҙдёӯеӣҪз”өдҝЎВ CN2В ејҖе§ӢдёҖжңҹе»әи®ҫгҖӮеңЁиҝҷдёҖе№ҙеҮәзҺ°з”өдҝЎзә§д»ҘеӨӘзҪ‘жҰӮеҝөпјҢеҜ№еӨ§йғЁеҲҶдәәеҸҜиғҪдёҚеӨӘзҶҹжӮүиҝҷдёӘеҗҚиҜҚпјҢдҪҶе®ғзЎ®е®һжҳҜйҮҢзЁӢзў‘ејҸзҡ„жҰӮеҝөжҸҗеҮәгҖӮ2005е№ҙе·ҰеҸіпјҢе…ЁзҗғйӘЁе№ІзҪ‘з»ңеҹәзЎҖе»әи®ҫеӨ§и§„жЁЎе…ҙиө·гҖӮ

- 第дёүйҳ¶ж®өпјҢ2006е№ҙ SDN иҜһз”ҹпјҢ2006е№ҙиҮід»ҠпјҢSDN зҡ„жҰӮеҝөжҸҗеҮәе·Іжңү11е№ҙж—¶й—ҙпјҢеңЁдёӯеӣҪе•Ҷз”ЁиҗҪең°зҡ„йЎ№зӣ®е№¶дёҚеӨҡгҖӮ2009е№ҙзҡ„ж—¶еҖҷпјҢOpenflow1.0 жӯЈејҸеҸ‘еёғпјҢеңЁе…ЁзҗғжҺҖиө·дәҶдёҖйҳөйЈҺжҪ®пјҢеӨ§е®¶еҘҪеғҸзңӢеҲ°дёҖдёқеёҢжңӣпјҢзҪ‘з»ңејҖе§Ӣж”№еҸҳдәҶгҖӮOpenflow1.0 еҸ‘еёғеҗҺпјҢжҺҘзқҖеҮ е№ҙжІЎжңүд»»дҪ•еҠЁдҪңгҖӮ2011е№ҙејҖе§Ӣ ONF зҡ„жҲҗз«ӢеёҰеҠЁдәҶдёҖжҠҠж–°зҡ„жөӘжҪ®пјҢ2012е№ҙи°·жӯҢB4е…ЁйқўиҝҗиЎҢпјҢ2013е№ҙ OpenDaylight еҸ‘еёғпјҢ2014е№ҙ ONOS еҸ‘еёғгҖӮеҗ„иЎҢеҗ„дёҡзҡ„зҺ©е®¶ејҖе§Ӣиҝӣе…ҘSDNйўҶеҹҹгҖӮ

1.2 SDNзҡ„е…ҙиө·

е·Ұдҫ§ Linux еҹәйҮ‘дјҡгҖҒONFгҖҒON.LABпјҢжҳҜеӣҪйҷ…зҹҘеҗҚзҡ„дёүдёӘ SDN зӣёе…ізҡ„з»„з»ҮгҖӮдёӯй—ҙйғЁеҲҶжҳҜејҖжәҗйЎ№зӣ®пјҢеҢ…жӢ¬ ONOSгҖҒODLгҖҒOPNFVпјҢзҺ°еңЁ ONAP жӯЈеңЁиҝӣиЎҢ OPEN-O е’Ң ECOMP дёӨдёӘйЎ№зӣ®зҡ„д»Јз ҒеҗҲ并гҖӮ

еҸідҫ§жҳҜзӣёе…іеҺӮе•ҶпјҢеҢ…жӢ¬ BarefootгҖҒbigswitchзӯүпјҢиҝҷдәӣйғҪжҳҜеҒҡSDNиҠҜе’Ңзӣ’еӯҗзҡ„硬件еҺӮе•ҶгҖӮиҝҷеҮ е№ҙпјҢиҝҷдәӣеӣҪйҷ…йғЁеҲҶSDNеҸ‘еұ•йғҪеҫҲеҝ«пјҢжңҖеҸідҫ§жҳҜиҝ‘еҮ е№ҙзҡ„еҲқеҲӣе…¬еҸёпјҢеҢ…жӢ¬ViptelaгҖҒvelocloudпјҢжңҖеҗҺдёӨдёӘжҳҜеҒҡCXгҖҒIXгҖҒDXдёҡеҠЎгҖӮ

еңЁеӣҪйҷ…дёҠпјҢдёҚз®ЎжҳҜејҖжәҗз»„з»ҮгҖҒејҖжәҗйЎ№зӣ®гҖҒеҲқеҲӣе…¬еҸёиҝҳжҳҜдёҺSDNзӣёе…ізҡ„йЎ№зӣ®пјҢеңЁеӣҪеҶ…еҸ‘еұ•зЎ®е®һжҜ”иҫғзј“ж…ўпјҢжҲ‘жІЎжңүеҲ—еҮәеӣҪеҶ…SDNзӣёе…ізҡ„е…¬еҸёпјҢиғҪе•Ҷз”ЁиҗҪең°зҡ„е°‘д№ӢеҸҲе°‘гҖӮ

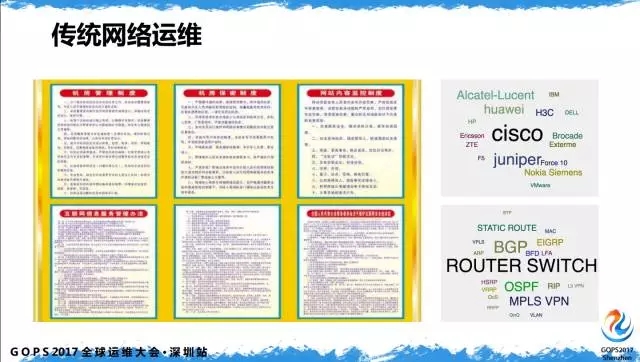

2гҖҒдј з»ҹзҪ‘з»ңиҝҗз»ҙзҺ°зҠ¶

SDN иҝҗз»ҙеҲ°еә•ж¶үеҸҠд»Җд№Ҳпјҹдј з»ҹзҪ‘з»ңиҝҗз»ҙпјҢж»Ўеўҷзҡ„иҝҗз»ҙи§„з« еҲ¶еәҰеҸӘжҳҜз»ҷдәәзңӢзҡ„пјҢиғҪзңҹжӯЈиҗҪе®һжү§иЎҢеӨҡе°‘пјҢеӨ§е®¶жҜ”иҫғжё…жҘҡгҖӮиҙҙдәҶеҶҚеӨҡзҡ„еҲ¶еәҰпјҢиҖҢзҪ‘з»ңиҝҗз»ҙдәәе‘ҳеңЁеҒҡд»Җд№Ҳе‘ўпјҹ

й’ҲеҜ№дёҚеҗҢеҺӮе•Ҷзҡ„硬件и®ҫеӨҮж•ІдёҚеҗҢзҡ„е‘Ҫд»ӨиЎҢпјҢд»Һ CiscoгҖҒjuniperгҖҒеҲ°еҚҺдёәгҖҒеҚҺдёүпјҢеҸҳеҢ–зҡ„еҸӘжҳҜжҚўдёҖз§Қе‘Ҫд»Өshow / display гҖҒno/undoгҖӮзҪ‘з»ңиҝҗз»ҙеңЁж•ҙдёӘиҝҗз»ҙдҪ“зі»йҮҢиғҢй”…иғҢеҫ—жңҖдёҘйҮҚпјҢдёҠеұӮдёҡеҠЎеҮәзҺ°й—®йўҳпјҢдјҡж—¶дёҚж—¶зҡ„жҠҠиҝҷдёӘй”…жү”еҲ°зҪ‘з»ңиҝҗз»ҙпјҢзҪ‘з»ңиҝҗз»ҙжІЎең°ж–№жү”пјҢиҰҒд№ҲиҮӘе·ұиғҢпјҢиҰҒд№ҲжҢ–жҺҳжңәжқҘиғҢгҖӮ

иҝҗз»ҙйғЁй—ЁжҜҸеӨ©еңЁеҲ¶е®ҡдёҚеҗҢзҡ„и§„з« еҲ¶еәҰпјҢжңүдәӣ规模зҡ„дјҡжңүиҮӘе·ұзҡ„ејҖеҸ‘дәәе‘ҳеҜ№ејҖжәҗиҪҜ件е’ҢејҖжәҗдә§е“ҒеҒҡдәҢж¬ЎејҖеҸ‘гҖӮиҝҷдәӣе№ҙпјҢжҲ‘дёҖзӣҙеҸӮдёҺеӨ§еһӢзҪ‘з»ңзҡ„иҝҗз»ҙпјҢеҮ е№ҙеүҚжҺҘи§ҰиҝҮдёҖдёӘе…ёеһӢзҡ„зҪ‘з»ңиҝҗз»ҙйғЁй—ЁпјҢејҖе§Ӣ他们еӣўйҳҹеҸӘжңүеҚҒеҮ дәәпјҢеҪ“еӣӣдә”е№ҙеҗҺпјҢдёҡеҠЎзі»з»ҹеҸҳеҫ—жӣҙеӨҚжқӮпјҢзҪ‘з»ңи®ҫеӨҮж¶үеҸҠзҡ„з§Қзұ»и¶ҠжқҘи¶ҠеӨҡпјҢиҝҗз»ҙдәәе‘ҳд№ҹи¶ҠжқҘи¶ҠеӨҡпјҢеҹәжң¬зҝ»дәҶдёӨеҖҚгҖӮ他们еңЁеҒҡзҡ„е°ұжҳҜ 7*24 е°Ҹж—¶еҖјзҸӯзӣ‘жҺ§пјҢе‘ҠиӯҰдёҚж–ӯзҡ„е“ҚгҖӮдёҚеҒңзҡ„еҶҷеҗ„з§Қж•…йҡңжҠҘе‘ҠпјҢзј–еҮәеҗ„з§Қеҗ„ж ·зҡ„ж•…йҡңжҠҘе‘ҠжЁЎжқҝгҖӮиҝҷжҳҜжҲ‘们жӯЈеёёзҪ‘з»ңиҝҗз»ҙеңЁеҒҡзҡ„дәӢжғ…пјҢиҝҷд№ҹжҳҜдј з»ҹиҝҗз»ҙзҡ„зҺ°зҠ¶гҖӮ

3гҖҒSDNзҪ‘з»ңиҝҗз»ҙ

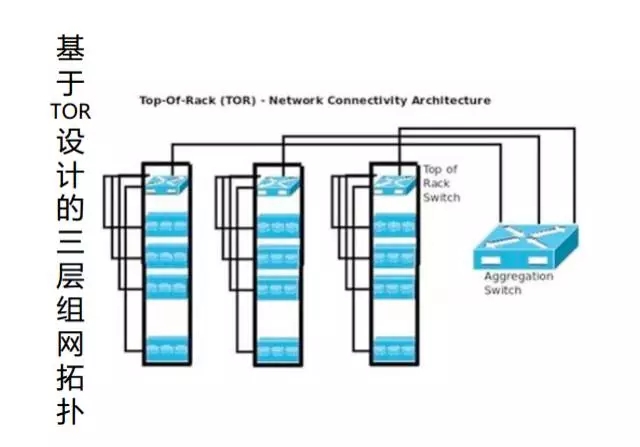

3.1 DCNзҪ‘з»ңжһ¶жһ„еҸҳиҝҒ

зҪ‘з»ңеңЁеҸ‘з”ҹд»Җд№Ҳж ·зҡ„еҸҳеҢ–пјҹжҲ‘们еҸӘиғҪзңӢеҲ°зҪ‘з»ңзҡ„еҸҳеҢ–пјҢжүҚиғҪзңӢеҲ°зҪ‘з»ңиҝҗз»ҙйңҖиҰҒеҜ№еә”еҒҡд»Җд№ҲеҸҳеҢ–гҖӮ

иҝҷжҳҜ DCN зҪ‘з»ңжһ¶жһ„еҸҳиҝҒпјҢд№ҹжҳҜе…ёеһӢдј з»ҹзҡ„дёүеұӮз»„зҪ‘жӢ“жү‘пјҢзӣёдҝЎеӨ§йғЁеҲҶзҪ‘з»ңиҝҗз»ҙдәәе‘ҳзҺ°еңЁз»ҙжҠӨзҡ„зҪ‘з»ңеҹәжң¬дёҠйғҪжҳҜиҝҷз§ҚзҪ‘з»ңгҖӮ

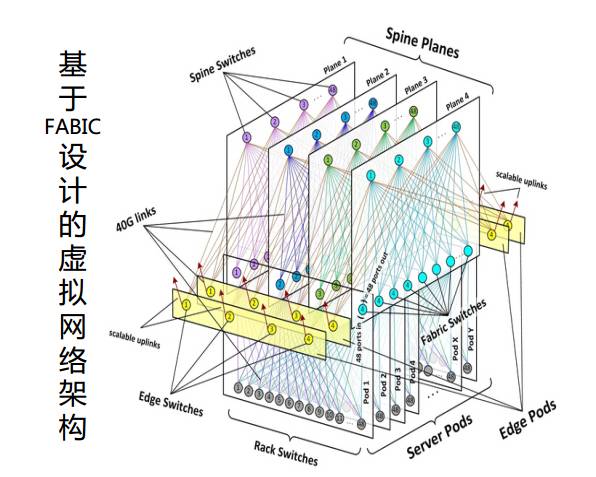

иҝҷжҳҜеҹәдәҺ FABIC и®ҫи®Ўзҡ„иҷҡжӢҹзҪ‘з»ңжһ¶жһ„пјҢжҺҘи§Ұ SDN жҜ”иҫғеӨҡзҡ„дәәеә”иҜҘзҹҘйҒ“иҝҷеј еӣҫпјҢиҝҷжҳҜ Facebook еүҚеҮ е№ҙжҸҗеҮәзҡ„DCNжһ¶жһ„еӣҫпјҢзҺ°еңЁ Facebook е·Із»Ҹе®һзҺ°дәҶеҹәдәҺ FABIC зҡ„жһ¶жһ„и®ҫи®ЎгҖӮдёәд»Җд№ҲйҮҮз”Ёиҝҷз§Қж–№ејҸпјҢеҺҹеӣ жҳҜзҺ°еңЁ CLOUDгҖҒNFV зӯүиҷҡжӢҹеҢ–жҠҖжңҜеҸ‘еұ•еӨӘеҝ«гҖӮ

жҷ®йҖҡзҡ„дёүеұӮз»„зҪ‘жһ¶жһ„ж— жі•ж»Ўи¶ізҺ°жңүзҡ„иҷҡжӢҹеҢ–дёҡеҠЎеҸ‘еұ•гҖӮжң¬жқҘдә‘е°ұжҳҜдёҖдёӘеҫҲеӨҚжқӮзҡ„иҷҡжӢҹеҢ–жһ¶жһ„пјҢж— жі•з”Ёдј з»ҹзҪ‘з»ңжһ¶жһ„ж”Ҝж’‘е®ғпјҢдәҺжҳҜж…ўж…ўиЎҚз”ҹеҮәеҹәдәҺFABICиҝҷж ·зҡ„иҪҜзЎ¬з»“еҗҲзҡ„иҷҡжӢҹзҪ‘з»ңжһ¶жһ„гҖӮ

3.2 йӘЁе№ІзҪ‘з»ңжһ¶жһ„еҸ‘еұ•

йӘЁе№ІзҪ‘з»ңжҠҖжңҜжј”иҝӣпјҢжҲ‘们д»ҠеӨ©дё»иҰҒиҜҙзҡ„жҳҜеҢәеҹҹйӘЁе№ІзҪ‘з»ңжһ¶жһ„зі»з»ҹгҖӮ

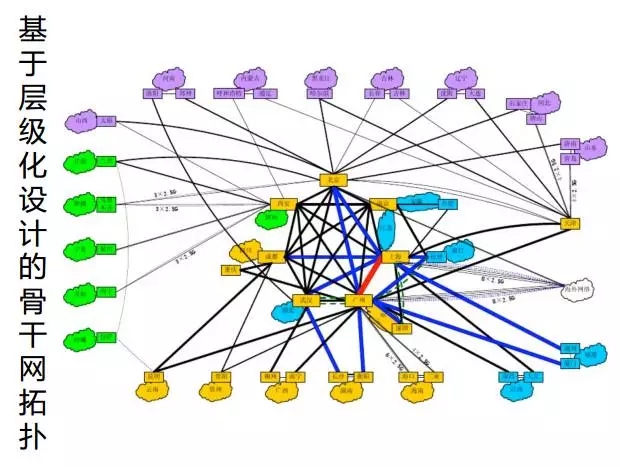

иҝҷжҳҜдёӯеӣҪжҹҗеј йӘЁе№ІзҪ‘жһ¶жһ„еӣҫпјҢеӨ§жҰӮжҳҜдәҢжңҹзҡ„гҖӮжң¬еӣҫеҸ‘еұ•е°Ҷиҝ‘10е№ҙпјҢжңүеҸҳеҢ–еҗ—пјҹжңүпјҢеўһеҠ дәҶзӮ№е’ҢзәҝпјҢзңӢдёҠеҺ»жӣҙеғҸдёҖеј иңҳиӣӣзҪ‘гҖӮ

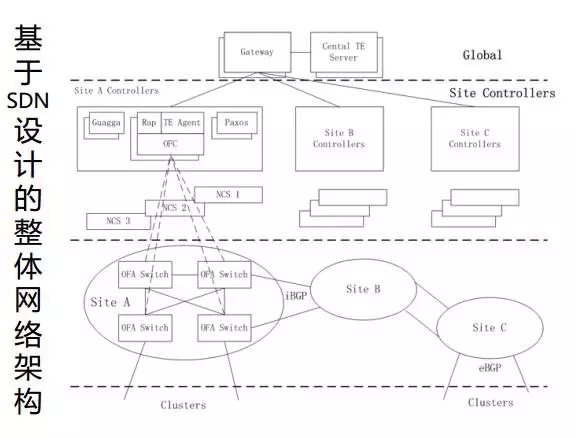

иҝҷжҳҜеҹәдәҺВ SDNВ и®ҫи®Ўзҡ„зҪ‘з»ңжһ¶жһ„еӣҫпјҢд№ҹеҸҜд»ҘеңЁВ internetВ дёҠжүҫеҲ°пјҢиҝҷжҳҜВ GoogleВ еүҚеҮ е№ҙзҡ„и®ҫи®ЎеӣҫгҖӮеә•еұӮжҳҜиҪ¬еҸ‘зҪ‘е…ғпјҢеҲҶдёәдёҚеҗҢзҡ„В SiteпјҢдёӯй—ҙжҳҜжҺ§еҲ¶йқўгҖӮеңЁдёӯй—ҙеұӮзҡ„ж—¶еҖҷпјҢcontrollerВ дҪҝз”ЁдёҚеҗҢзҡ„еҠҹиғҪжЁЎеқ—е®һзҺ°еҜ№еә•еұӮзҪ‘е…ғзҡ„жҺ§еҲ¶гҖӮжөҒйҮҸзҡ„и°ғеәҰе’ҢдјҳеҢ–еңЁжңҖдёҠеұӮзҡ„В TE serverВ дёҠеҒҡгҖӮ

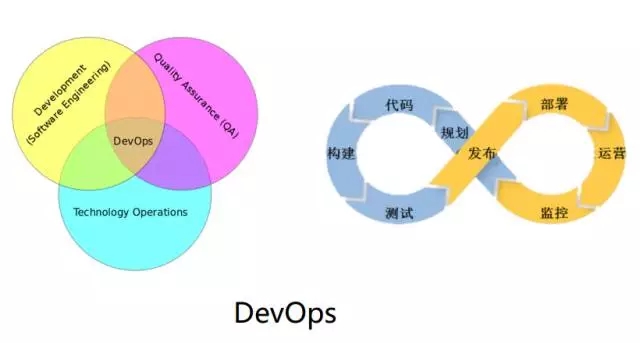

3.3 SDN NetDevOps

зҪ‘з»ңе·ҘзЁӢеёҲеҜ№ DevOps зҡ„зҗҶи§ЈдёҚеҰӮеҒҡзі»з»ҹејҖеҸ‘зҡ„е·ҘзЁӢеёҲпјҢиҝҷйҮҢе°ұйңҖиҰҒдёҚеҗҢе·Ҙз§Қзҡ„еҚҸеҗҢе·ҘдҪңгҖӮдёҠйқўжҳҜ DevOps иғҪеҠӣзҺҜпјҢд»Һ规еҲ’гҖҒд»Јз ҒеҲ°жөӢиҜ•гҖҒеҸ‘еёғе®ҢжҲҗдёҖдёӘе…ЁжөҒзЁӢй—ӯзҺҜпјҢеҸҰеӨ–дёҖдёӘжҳҜ DevOps е…іиҒ”зҡ„зҡ„з ”еҸ‘гҖҒжөӢиҜ•е’Ңиҝҗз»ҙдёүдёӘйғЁй—Ёе·ҘдҪңе…іиҒ”еӣҫпјҢдәӨйӣҶзҡ„ең°ж–№е°ұжҳҜ DevOpsгҖӮ

йҮҚзӮ№и°Ҳи°Ҳ NetworkпјҢиҝҷжҳҜй’ҲеҜ№еҗҺз»ӯеҮ е№ҙпјҢзӣёдҝЎеңЁеӣҪеҶ…жҳҜеҫҲеӨ§зҡ„з©әзјәгҖӮDevOps йқўеҗ‘зҡ„дәәзҫӨжӣҙеӨҡзҡ„жҳҜзі»з»ҹејҖеҸ‘гҖҒзі»з»ҹиҝҗз»ҙпјҢеҺҹжңүзҡ„зҪ‘з»ңзі»з»ҹжҳҜеұһдәҺдј з»ҹзҪ‘е·ҘеҒҡзҡ„гҖӮ

зҺ°еңЁеӣҪеҶ…дј з»ҹзҪ‘е·Ҙдјҡи„ҡжң¬зҡ„йғҪдёҚеӨҡпјҢиғҪеҗҰи®©дј з»ҹзҪ‘з»ңе’Ң DevOps з»“еҗҲиө·жқҘпјҹзӯ”жЎҲжҳҜеҸҜд»ҘпјҢзҺ°жңүзҡ„дј з»ҹзҪ‘з»ңеҸҜд»Ҙе’Ң DevOps з»“еҗҲпјҢеҪўжҲҗ NetDevOpsгҖӮеңЁ SDN еҮәзҺ°еҗҺпјҢNetDevOps еҸҜд»ҘеҸ‘жҢҘжӣҙеӨ§зҡ„дјҳеҠҝгҖӮ

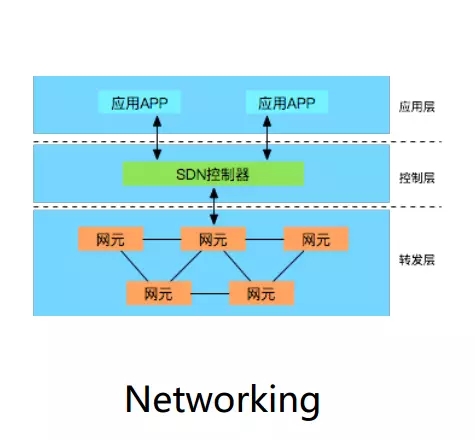

еңЁВ SDNВ зі»з»ҹйҮҢпјҢжңүзӢ¬з«Ӣзҡ„дёӯеӨ®жҺ§еҲ¶еҷЁе’ҢдёҠеұӮеә”з”ЁеұӮпјҢиҪ¬еҸ‘еұӮеҸӘжҳҜдҪңдёәжңҖеә•еұӮзҡ„ж•°жҚ®иҪ¬еҸ‘пјҢдёҡеҠЎзј–жҺ’еңЁжҺ§еҲ¶еҷЁеҒҡпјҢжҺ§еҲ¶еҷЁжҳҜзәҜиҪҜ件系з»ҹпјҢиҝҷеҘ—зі»з»ҹеҸҜд»Ҙе®һзҺ°еҜ№еӨ–APIеҜ№жҺҘпјҢиҝҷж—¶еҖҷВ DevOpsВ еҸҜд»ҘзңҹжӯЈдҪ“зҺ°еҮәд»·еҖјгҖӮ

дј з»ҹзҪ‘з»ңеҰӮдҪ•е’ҢВ DevOpsВ з»“еҗҲпјҹзҺ°жңүзҡ„дј з»ҹзҪ‘з»ңи®ҫеӨҮжҳҜй—ӯзҺҜзі»з»ҹпјҢзӣ®еүҚеӨ§йғЁеҲҶзҡ„зҪ‘з»ңи®ҫеӨҮиҝҳжҳҜеҹәдәҺВ CLIВ е‘Ҫд»ӨиЎҢпјҢж–°зҡ„硬件 OSВ зі»з»ҹж”ҜжҢҒВ PCEPгҖҒNETCONFВ зӯүеҚҸи®®пјҢDevOpsВ е’ҢВ NetworkВ еҸӘиғҪз»“еҗҲеҲ°иҝҷйҮҢпјҢж— жі•и·ҹдёҡеҠЎеұӮеҒҡе…іиҒ”е’ҢйҖӮй…ҚгҖӮ

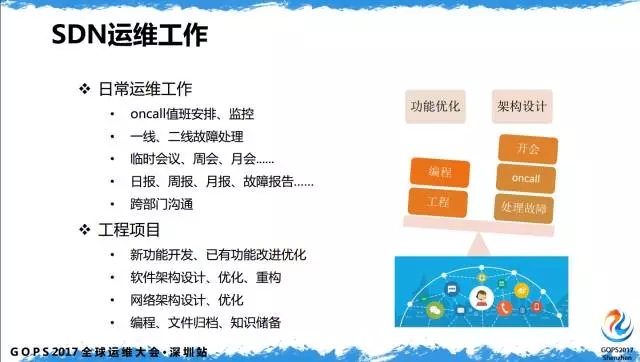

3.4 SDNзҡ„иҝҗз»ҙе·ҘдҪң

SDN иҝҗз»ҙе·ҘдҪңпјҢдё»иҰҒеҢ…жӢ¬дёӨж–№йқўпјҢдёҖжҳҜж—Ҙеёёиҝҗз»ҙе·ҘдҪңпјҢдәҢжҳҜе·ҘзЁӢйЎ№зӣ®гҖӮж—Ҙеёёиҝҗз»ҙе·ҘдҪңе’ҢзҺ°еңЁдј з»ҹзҪ‘з»ңзҡ„иҝҗз»ҙзӣёдјјпјҢеҢ…жӢ¬еҖјзҸӯзӣ‘жҺ§гҖҒдёҖдәҢзәҝж•…йҡңеӨ„зҗҶгҖҒеҗ„з§Қдјҡи®®гҖҒеҗ„з§ҚжҠҘе‘Ҡд»ҘеҸҠи·ЁйғЁй—ЁжІҹйҖҡгҖӮ

йҮҚзӮ№жҳҜи·ЁйғЁй—ЁжІҹйҖҡпјҢеҰӮжһңдҪ зҺ°еңЁд»ҺдәӢдј з»ҹзҪ‘з»ңиҝҗз»ҙпјҢдҪ жү“дәӨйҒ“зҡ„йғЁй—ЁжҳҜжңүйҷҗзҡ„пјҢиҝҷжҳҜдёҖдёӘзӣёеҜ№е°Ғй—ӯзҡ„йғЁй—ЁгҖӮе®ғи·ҹдёҠеұӮгҖҒеә”з”ЁйғЁй—Ёзҡ„е…іиҒ”еәҰеҫҲдҪҺпјҢSDNеҢ–еҗҺдјҡж¶үеҸҠеҫҲеӨҡйғЁй—ЁпјҢеӣ дёә SDN зҡ„иҝҗз»ҙиҰҒеҸӮдёҺжөӢиҜ•гҖҒз ”еҸ‘гҖӮиҝҷж—¶еҖҷдҪ зҡ„иҝҗз»ҙиҰҒжҸҗй«ҳдёҖдёӘеұӮйқўпјҢиҰҒжӣҙеӨҡзҡ„и·ҹзі»з»ҹејҖеҸ‘гҖҒиҪҜ件ејҖеҸ‘еҒҡдә’еҠЁпјҢDevOpsиҝҗз»ҙжҒ°еҘҪд№ҹж¶өзӣ–дәҶиҝҷдёүдёӘж–№йқўгҖӮ

иҝҗз»ҙйҮҢиҝҳжңүдёҖдёӘйҮҚиҰҒзҡ„йғЁеҲҶпјҢеј•е…Ҙе·ҘзЁӢйЎ№зӣ®гҖӮиҝҷйҮҢзҡ„е·ҘзЁӢйЎ№зӣ®жҢҮзҡ„дёҚжҳҜзҪ‘з»ңиҝҗз»ҙгҖҒзҪ‘з»ңи®ҫи®Ўзҡ„йЎ№зӣ®пјҢжҢҮзҡ„жҳҜдёҺиҪҜ件ејҖеҸ‘гҖҒиҪҜ件жһ¶жһ„и®ҫи®Ўд»ҘеҸҠжһ¶жһ„дјҳеҢ–зӣёе…ізҡ„пјҢз»ҹз§°дёәе·ҘзЁӢйЎ№зӣ®гҖӮ

ж–°зҡ„еҠҹиғҪејҖеҸ‘еҢ…жӢ¬е·ІжңүеҠҹиғҪејҖеҸ‘дјҳеҢ–пјҢиҝҷйғЁеҲҶжҳҜзҪ‘з»ңиҝҗз»ҙеңЁеҒҡзҡ„гҖӮиҝҷдёӘйғЁй—ЁжҳҜз”ұзҪ‘е·Ҙе’ҢиҪҜе·Ҙз»„жҲҗзҡ„SDNиҝҗз»ҙйғЁй—ЁпјҢд№ҹеҸҜд»ҘжҳҜдёҖдёӘиҷҡжӢҹеӣўйҳҹпјҢиҝҷж ·зҡ„е·Ҙз§Қжҗӯй…ҚеңЁSDNиҝҗз»ҙйҮҢйқһеёёеёёи§ҒгҖӮ

еңЁеҺ»е№ҙд»ҘеүҚпјҢи°·жӯҢ SRE еҫҲеҮәеҗҚпјҢSRE зҡ„д№Ұзҝ»иҜ‘жҲҗдёӯж–ҮпјҢиҮід»ҠйқһеёёзҒ«гҖӮе»әи®®еҒҡзҪ‘з»ңиҝҗз»ҙзҡ„дәәеҸҜд»ҘзңӢзңӢиҝҷжң¬д№ҰгҖӮиҝҷжң¬д№ҰжҸҗеҲ°иҝҷдёӨйғЁеҲҶпјҢйҮҢйқўжңүдёҖж®өиҜқиҜҙеҫ—зү№еҲ«еҘҪвҖңд»»дҪ•дёҖдёӘиҝҗз»ҙе·ҘзЁӢеёҲиҰҒжңү50%зҡ„ж—¶й—ҙз”ЁжқҘејҖеҸ‘гҖҒеҶҷд»Јз ҒвҖқгҖӮ

еңЁSDNйҮҢпјҢдёҚд»…д»…жҳҜзҪ‘з»ңи®ҫеӨҮпјҢдёҚйңҖиҰҒдҪ зӣҙжҺҘж•Іе‘Ҫд»ӨгҖҒзҷ»йҷҶи®ҫеӨҮпјҢд»–зҡ„ж“ҚдҪңгҖҒиҝҗз»ҙгҖҒз®ЎзҗҶеҫҲеӨҡиҰҒйқ зі»з»ҹе®ҢжҲҗпјҢзі»з»ҹжҳҜйңҖиҰҒејҖеҸ‘зҡ„гҖӮеҰӮжһңдҪ зҡ„еӨ§йғЁеҲҶж—¶й—ҙиў«ж—Ҙеёёиҝҗз»ҙеҚ з”ЁпјҢзүәзүІзҡ„жҳҜдҪ зҡ„з»ҸйӘҢгҖӮ

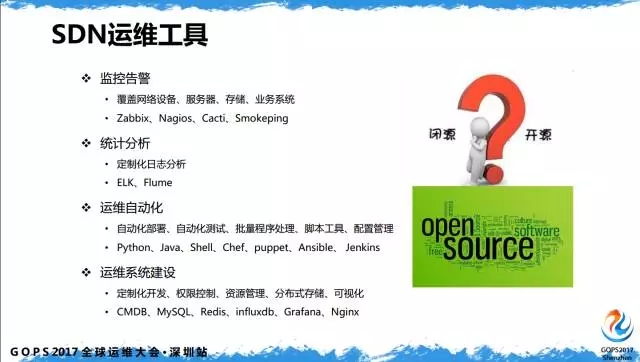

3.5 SDNиҝҗз»ҙе·Ҙе…·

SDN иҝҗз»ҙзҡ„еёёз”Ёе·Ҙе…·пјҢеңЁдј з»ҹиҝҗз»ҙе’Ңзі»з»ҹиҝҗз»ҙд№ҹдјҡдҪҝз”ЁпјҢеҢ…жӢ¬ CactiгҖҒSmokepingгҖҒNagiosгҖҒZabbixпјҢжҲ‘们жӣҙеҖҫеҗ‘дәҺејҖжәҗпјҢдј з»ҹзҪ‘з»ңжӣҙеҖҫеҗ‘дәҺй—ӯжәҗпјҢйңҖиҰҒзҪ‘з»ңе·ҘзЁӢеёҲеӯҰд№ жӣҙеӨҡзҡ„ејҖжәҗиҪҜ件пјҢиҮӘе·ұеҒҡдәҢж¬ЎејҖеҸ‘пјҢеҒҡеҮәйҖӮеҗҲиҮӘе·ұж—Ҙеёёиҝҗз»ҙзҡ„е·Ҙе…·гҖӮ

4гҖҒSDNиҮӘеҠЁеҢ–иҝҗз»ҙ

иҝҗз»ҙеҢ…жӢ¬е‘ҠиӯҰзӣ‘жҺ§гҖҒз»ҹи®ЎеҲҶжһҗгҖҒиҝҗз»ҙиҮӘеҠЁеҢ–е’Ңиҝҗз»ҙзі»з»ҹзҡ„е»әи®ҫгҖӮSDNиҮӘеҠЁеҢ–иҝҗз»ҙзі»з»ҹпјҢиҝҷдёӘзі»з»ҹ并дёҚжҳҜдёҖдёӘе№іеҸ°гҖҒдёҖдёӘе·Ҙе…·пјҢиҖҢжҳҜдёҖдёӘдҪ“зі»гҖҒдёҖдёӘж–№жі•гҖӮе№іеҸ°жҳҜиҝҗз»ҙзі»з»ҹзҡ„дёҖйғЁеҲҶпјҢиҝҗз»ҙиҮӘеҠЁеҢ–е®Ңе…Ёи·ҹејҖеҸ‘зӣёе…іпјҢе®ғдёҚеңЁе№іеҸ°еҶ…пјҢе№іеҸ°еҶ…жӣҙеӨҡзҡ„жҳҜзӣ‘жҺ§е‘ҠиӯҰгҖҒз»ҹи®ЎеҲҶжһҗпјҢеҒҡеҲ°иҝҗз»ҙзі»з»ҹзҡ„е»әи®ҫгҖӮиҝҗз»ҙиҮӘеҠЁеҢ–жӣҙеӨҡзҡ„дёҺ DevOps зӣёе…ігҖӮ

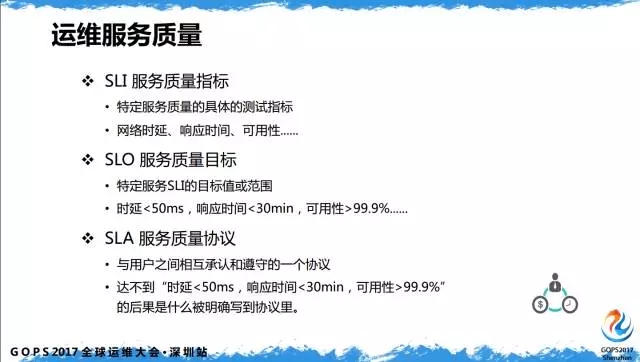

4.1 иҝҗз»ҙжңҚеҠЎиҙЁйҮҸи®ҫи®Ў

иҝҗз»ҙжңҚеҠЎиҙЁйҮҸпјҢеңЁдј з»ҹзҡ„зҪ‘з»ңиҝҗз»ҙйҮҢпјҢзҪ‘з»ңе·ҘзЁӢеёҲз»ҸеёёжҸҗеҮә SLAгҖӮдҪңдёәиҝҗз»ҙдәәе‘ҳжІЎеҝ…иҰҒе…іеҝғ SLAпјҢSLA жҳҜжңҚеҠЎиҙЁйҮҸеҚҸи®®гҖӮиҝҗз»ҙдәәе‘ҳйңҖиҰҒе…іжіЁзҡ„жҳҜ SLI е’Ң SLOпјҢжҲ‘们йңҖиҰҒжүҫеҲ°жңҚеҠЎиҙЁйҮҸзҡ„жҢҮж ҮжҳҜд»Җд№ҲпјҢж №жҚ®жҢҮж ҮеҲ¶е®ҡзӣ®ж ҮгҖӮ

иҮідәҺSLAпјҢиҝҷжҳҜе’Ңз”ЁжҲ·д№Ӣй—ҙжүҝиҜәйҒөе®Ҳзҡ„еҚҸи®®пјҢжҲ‘们еңЁдј з»ҹзҪ‘з»ңйҮҢжӣҙеӨҡзҡ„е…іеҝғзҪ‘з»ң时延е’ҢзҪ‘з»ңдёўеҢ…зҺҮпјҢжҲ‘们йңҖиҰҒиҖғйҮҸжӣҙеӨҡзҡ„жңҚеҠЎжҢҮж ҮпјҢеҫҲеӨҡи·ҹдёҠеұӮеә”з”ЁеҒҡе…іиҒ”гҖӮ

зҪ‘з»ң时延гҖҒдёўеҢ…зҺҮд»ҘеҸҠз«ҜеҲ°з«ҜйғҪеҸҜд»ҘдҪңдёәиЎЎйҮҸзҡ„жҢҮж ҮпјҢжҲ‘д»¬ж №жҚ®иҝҷдёӘжҢҮж ҮеҲ¶е®ҡSLOпјҢдҫӢеҰӮпјҢдҪ зҡ„时延иҰҒе°‘дәҺ50жҜ«з§’пјҢеҸҜз”ЁжҖ§иҰҒеӨ§дәҺ99.9%пјҢиҝҷжҳҜиҝҗз»ҙдәәе‘ҳйңҖиҰҒе…іжіЁзҡ„йғЁеҲҶгҖӮ

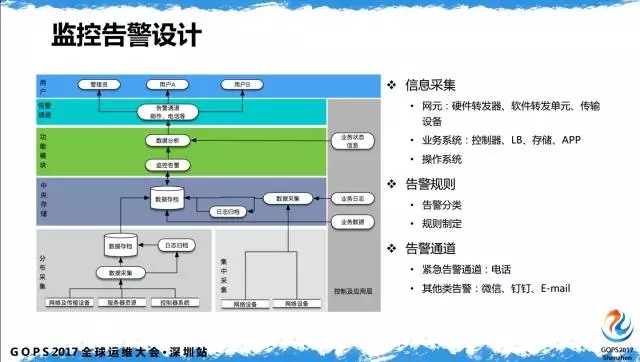

4.2 зӣ‘жҺ§е‘ҠиӯҰи®ҫи®Ў

иҝҗз»ҙе№іеҸ°гҖҒиҝҗз»ҙзі»з»ҹйҮҢж¶үеҸҠзҡ„еҶ…е®№пјҢдёҖжҳҜзӣ‘жҺ§е‘ҠиӯҰи®ҫи®ЎпјҢйҖҡеёёд»ҺжңҖеә•еұӮзҡ„йҮҮйӣҶгҖҒеӯҳеӮЁгҖҒеҠҹиғҪжЁЎеқ—ејҖеҸ‘гҖҒдёҠеұӮе‘ҠиӯҰйҖҡйҒ“гҖҒз”ЁжҲ·дҫ§гҖӮд»ҺйҮҮйӣҶжқҘи®ІпјҢеҰӮжһңиҝҗз»ҙеҸӘжҳҜIDCжҲ–иҖ…еҹҺеҹҹзҪ‘пјҢиҝҷж—¶еҖҷдҪ йңҖиҰҒйӣҶдёӯйҮҮйӣҶгҖҒйӣҶдёӯеӯҳеӮЁгҖӮ

еҰӮжһңдҪ з»ҙжҠӨзҡ„жҳҜе…ЁеӣҪжҖ§д№ғиҮіе…ЁзҗғжҖ§зҡ„зҪ‘з»ңпјҢдҪ йңҖиҰҒеҲҶеёғејҸйҮҮйӣҶгҖӮзҺ°еңЁеӨ§жІідә‘иҒ”зҡ„SDNжҺ§еҲ¶еҷЁз®ЎзҗҶзқҖеҲҶеёғеңЁе…Ёзҗғе°Ҷиҝ‘100дёӘиҪ¬еҸ‘иҠӮзӮ№пјҢеҜ№дәҺиҝҷз§Қ规模пјҢж— жі•йҮҮз”ЁйӣҶдёӯејҸпјҢйңҖиҰҒж №жҚ®иҮӘе·ұзҡ„дёҡеҠЎеҲҶеёғзӮ№пјҢеҲ¶е®ҡдёҚеҗҢеҢәеҹҹжҖ§зҡ„еҲҶеёғйҮҮйӣҶпјҢеҢ…жӢ¬еӯҳеӮЁгҖӮйғЁзҪІдёӯеӨ®еӯҳеӮЁе’ҢеҲҶеёғејҸеӯҳеӮЁпјҢеҲҶеёғйҮҮйӣҶеҗҺе®һж—¶еҗҢжӯҘеҲ°дёӯеӨ®еӯҳеӮЁпјҢеҗҢж—¶йңҖиҰҒеңЁжң¬ең°еӯҳеӮЁеҗҺеҒҡеӨҮд»ҪгҖӮ

еҠҹиғҪжЁЎеқ—ж–№йқўпјҢеҸӘжҸҗеҲ°ж•°жҚ®еҲҶжһҗпјҢдёәд»Җд№Ҳзӣ‘жҺ§е‘ҠиӯҰе’Ңе‘ҠиӯҰйҖҡйҒ“д№Ӣй—ҙеўһеҠ дәҶдёҖеұӮеҲҶжһҗпјҢдҪ еңЁеә•еұӮеҒҡйҮҮйӣҶзҡ„ж—¶еҖҷпјҢйҮҮйӣҶзҡ„жҳҜеҺҹе§Ӣж•°жҚ®пјҢ规еҲҷжҳҜйҖҡиҝҮеҺҹжңүзі»з»ҹзҡ„规еҲҷпјҢд»Һзӣ‘жҺ§е‘ҠиӯҰеҲ°е‘ҠиӯҰйҖҡйҒ“пјҢеҒҡдёҖдёӘдёӯй—ҙеұӮпјҢиҝҷжҳҜж №жҚ®иҮӘе·ұзҪ‘з»ңжғ…еҶөеҒҡзҡ„иҮӘе®ҡд№үзҡ„规еҲҷгҖӮ

4.3 зӣ‘жҺ§е‘ҠиӯҰеҲҶжһҗ

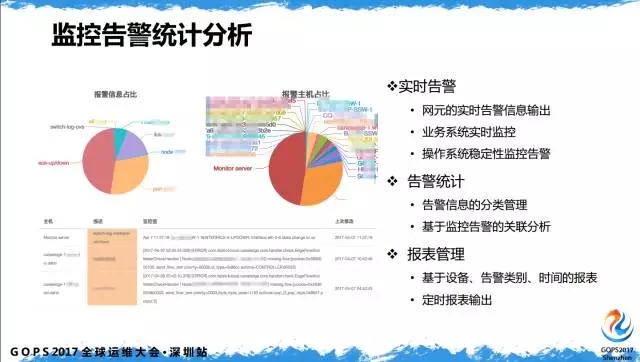

е‘ҠиӯҰз»ҹи®ЎеҲҶжһҗпјҢжӢҝеҲ°е‘ҠиӯҰеҺҹе§Ӣж•°жҚ®еҗҺпјҢеҰӮдҪ•жӣҙеҘҪзҡ„еұ•зҺ°еҮәжқҘпјҢеҰӮдҪ•жҠҠжңүз”Ёзҡ„дҝЎжҒҜе®һж—¶еҗҢжӯҘгҖӮе®һж—¶е‘ҠиӯҰдёҚеғҸдј з»ҹзҪ‘з»ңеҸӘжңүеә•еұӮиҪ¬еҸ‘пјҢиҝҷж¶үеҸҠдёҡеҠЎзі»з»ҹзҡ„е®һж—¶зӣ‘жҺ§е’ҢзҪ‘е…ғе®һж—¶зӣ‘жҺ§пјҢеҢ…жӢ¬ж“ҚдҪңзі»з»ҹзЁіе®ҡжҖ§зҡ„зӣ‘жҺ§пјҢйғҪдјҡз»ҹдёҖзҡ„еңЁдёҖдёӘзӣ‘жҺ§е№іеҸ°еҒҡгҖӮ

е‘ҠиӯҰз»ҹи®ЎпјҢйңҖиҰҒеҜ№жүҖжңүе‘ҠиӯҰдҝЎжҒҜеҒҡеҲҶзұ»з®ЎзҗҶпјҢеҸӘжңүжҠҠжңүз”Ёзҡ„дҝЎжҒҜеҲҶзұ»еҗҺпјҢжүҚиғҪиҝӣиЎҢ第дәҢжӯҘеҲҶжһҗгҖӮжҠҘиЎЁз®ЎзҗҶпјҢеҫҲеӨҡ SLI е’Ң SLO зҡ„жқҘиҮӘдәҺжҠҘиЎЁпјҢдёҚз®ЎжҳҜи®ҫеӨҮгҖҒй“ҫи·ҜгҖҒзі»з»ҹзҡ„еҸҜз”ЁжҖ§д»ҺдҪ•иҖҢжқҘпјҢиҝҷжҳҜйҖҡиҝҮе‘ҠиӯҰз»ҹи®ЎеҲҶжһҗжҠҘиЎЁеҠҹиғҪиҫ“еҮәпјҢдҪ еҸҜд»Ҙе®ҡжңҲгҖҒе®ҡе‘ЁеҜ№и®ҫеӨҮгҖҒй“ҫи·ҜеҒҡSLAйңҖиҰҒзҡ„з»ҹи®ЎгҖӮ

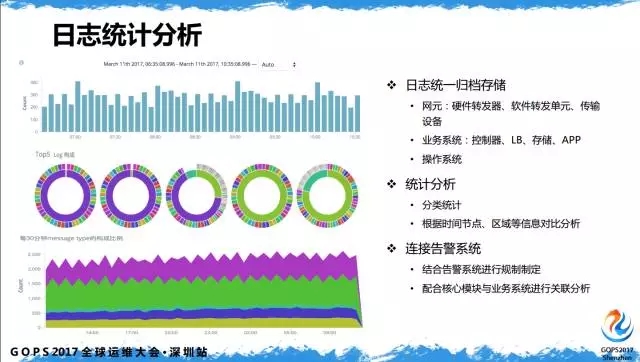

4.4 ж—Ҙеҝ—з»ҹи®ЎеҲҶжһҗ

ж—Ҙеҝ—з»ҹи®ЎеҲҶжһҗпјҢпјҲе·Ұеӣҫпјүеј•з”ЁдәҶжІЎжңүеҒҡдәҢж¬ЎејҖеҸ‘зҡ„еӣҫпјҢеҫҲеӨҡе…¬еҸёйғҪеңЁз”ЁELKпјҢиҝҷжҳҜELKзҡ„еҲҶжһҗеҠҹиғҪпјҢеҸҜд»Ҙй’ҲеҜ№иҮӘе·ұзҡ„дёҡеҠЎзі»з»ҹеҒҡдёҚеҗҢзҡ„е®ҡеҲ¶ејҖеҸ‘пјҢеҸҜд»ҘеҲ¶е®ҡдҪҸдёҚеҗҢзҡ„з»ҹи®ЎеҲҶжһҗжЁЎеқ—гҖӮ

ж—Ҙеҝ—еҢ…жӢ¬е…ЁеҘ—SDNзі»з»ҹпјҢд»ҺдёҠеұӮжҺ§еҲ¶зі»з»ҹпјҢдёӯеұӮж“ҚдҪңзі»з»ҹгҖҒеӯҳеӮЁгҖҒдёҡеҠЎзј–жҺ’пјҢеә•еұӮиҪ¬еҸ‘зҪ‘е…ғпјҢиҝҷйҮҢзҡ„зҪ‘е…ғеҢ…жӢ¬еӨҡз§Қзұ»еһӢпјҢжңҖеҗҺжҳҜеә•еұӮдј иҫ“гҖӮиҝҷжҳҜдј з»ҹзҪ‘з»ңдёҚдјҡж¶үеҸҠзҡ„пјҢдј з»ҹзҪ‘з»ңзҡ„зҪ‘з»ңиҝҗз»ҙдәәе‘ҳеҸӘдјҡе…іжіЁзҪ‘з»ңи®ҫеӨҮпјҢеңЁ SDN зі»з»ҹйҮҢпјҢж—Ҙеҝ—йҮҮйӣҶд»ҘеҸҠиҝҗз»ҙз®ЎзҗҶеҢ…еҗ«еә•еұӮдј иҫ“е’ҢдёҠеұӮеә”з”ЁгҖӮ

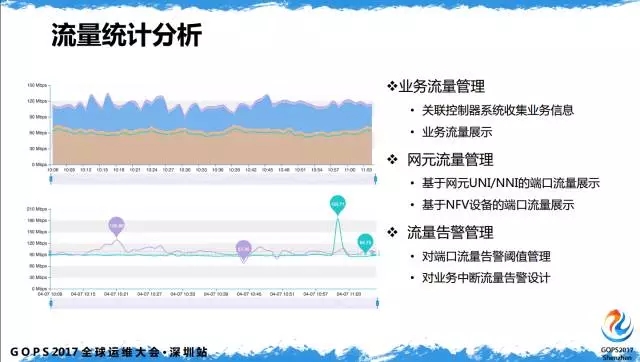

4.5 жөҒйҮҸз»ҹи®ЎеҲҶжһҗ

жөҒйҮҸз»ҹи®ЎеҲҶжһҗпјҢзҺ°еңЁзҪ‘з®Ўзі»з»ҹе’Ңиҝҗз»ҙдәәе‘ҳе…іжіЁи®ҫеӨҮжөҒйҮҸгҖҒз«ҜеҸЈжөҒйҮҸпјҢSDN йңҖиҰҒе…іжіЁж•ҙжқЎй“ҫи·Ҝз«ҜеҸЈпјҢжӣҙйҮҚиҰҒзҡ„жҳҜдёҡеҠЎжөҒйҮҸпјҢSDN жңҖеӨ§зҡ„зү№зӮ№жҳҜиғҪеӨҹи·ҹдёҡеҠЎзі»з»ҹеҒҡеҲ°е…іиҒ”пјҢиғҪеӨҹйҖҡиҝҮиҝҗз»ҙзі»з»ҹжҹҘзңӢжүҖжңүдёҡеҠЎзӣёе…ізҡ„жөҒйҮҸдҝЎжҒҜгҖӮ

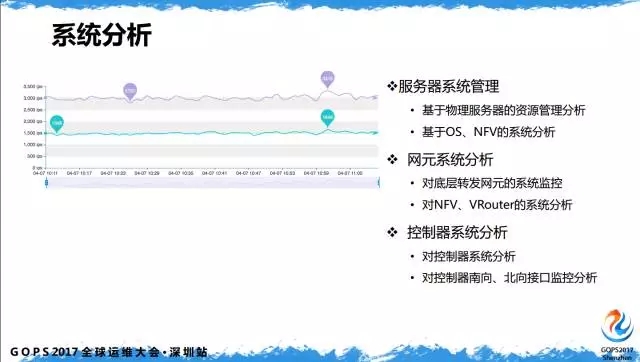

4.6 зі»з»ҹеҲҶжһҗ

зі»з»ҹеҲҶжһҗпјҢеҜ№дәҺеӨ§йғЁеҲҶиҝҗз»ҙдәәе‘ҳжқҘиҜҙжҜ”иҫғе®№жҳ“зҗҶи§ЈпјҢиҝҷжҳҜзү©зҗҶжңҚеҠЎеҷЁиө„жәҗе’Ңж“ҚдҪңзі»з»ҹиө„жәҗгҖӮ

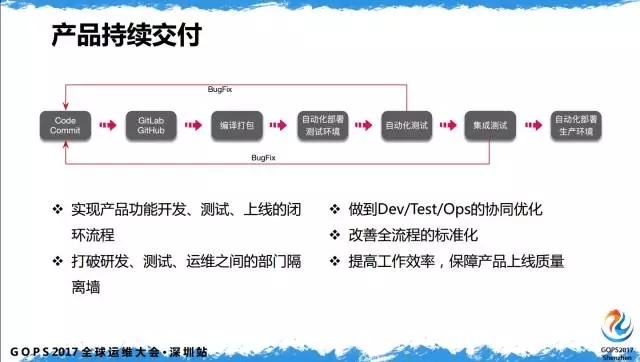

иҝҷеҮ дёӘзүҮеӯҗйҮҚзӮ№жҳҜ DevOpsпјҢжҺ§еҲ¶еҷЁзҡ„ејҖеҸ‘е’ҢдёҠзәҝпјҢз”ЁдәҶиҝҷеҮ е№ҙжҜ”иҫғзғӯзҡ„зІҫзӣҠз®ЎзҗҶгҖҒж•ҸжҚ·ејҖеҸ‘пјҢзӣёдҝЎеңЁеә§дәҶи§ЈеҫҲеӨҡгҖӮ

жҢҒз»ӯдәӨд»ҳпјҢжҢҮзҡ„жҳҜ SDN жҺ§еҲ¶еҷЁзі»з»ҹзҡ„жҢҒз»ӯдәӨд»ҳпјҢеҒҡеҲ°зүҲжң¬зҡ„еҝ«йҖҹиҝӯд»Је’Ңе®һж—¶е“Қеә”пјҢеҲ©з”ЁжөҒзЁӢз®ЎзҗҶжқҘжү“з ҙз ”еҸ‘гҖҒжөӢиҜ•гҖҒиҝҗз»ҙд№Ӣй—ҙзҡ„йҡ”зҰ»еўҷгҖӮдёҺиҝҗз»ҙзӣёе…ізҡ„жҳҜиҮӘеҠЁеҢ–йғЁзҪІгҖҒиҮӘеҠЁеҢ–жөӢиҜ•е’ҢйӣҶжҲҗжөӢиҜ•гҖӮ

иҮӘеҠЁеҢ–йғЁзҪІпјҢеҸҜд»ҘйӣҶжҲҗеҲ°иҮӘеҠЁеҢ–иҝҗз»ҙе№іеҸ°йҮҢпјҢеҸҜд»ҘдҪңдёәдёҖдёӘжЁЎеқ—йӣҶжҲҗеҲ°иҝҗз»ҙзі»з»ҹйҮҢпјҢд»ҺеҸ‘еёғгҖҒйғЁзҪІеҲ°дәӨд»ҳиҝҗиЎҢпјҢеҸҜд»ҘйҮҮз”ЁиҪ»йҮҸз®ҖжҙҒзҡ„е·Ҙе…·пјҢдҫӢеҰӮзӣ®еүҚжҜ”иҫғжөҒиЎҢзҡ„ ansibleгҖӮ

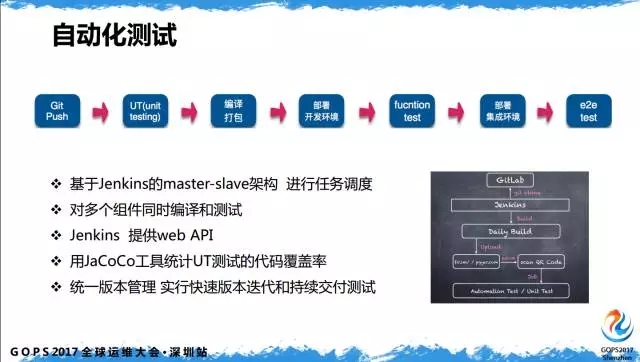

иҮӘеҠЁеҢ–жөӢиҜ•пјҢжөӢиҜ•еҲҶдёәдёӨйғЁеҲҶпјҢдёҖжҳҜиҮӘеҠЁеҢ–жөӢиҜ•пјҢдәҢжҳҜйӣҶжҲҗжөӢиҜ•гҖӮиҮӘеҠЁеҢ–жөӢиҜ•дё»иҰҒеҜ№жҺ§еҲ¶еҷЁејҖеҸ‘гҖҒд»Јз Ғзҡ„йҖ»иҫ‘жҖ§пјҢжӣҙеӨҡзҡ„жҳҜдёҺз ”еҸ‘йғЁй—Ёзҡ„жІҹйҖҡгҖӮ

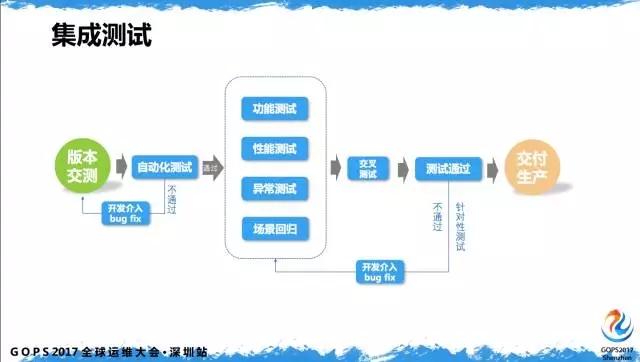

йӣҶжҲҗжөӢиҜ•пјҢиҝҷжҜ” DevOps жҸҗеҲ°зҡ„еӨҡдёҖдёӘйӣҶжҲҗжөӢиҜ•пјҢеӣ дёә SDN иҝҗиЎҢеңәжҷҜжӣҙеӨҡзҡ„иҪ¬еҸ‘йқўзҡ„и®ҫи®ЎгҖӮиҮӘеҠЁеҢ–жөӢиҜ•жҳҜйӘҢиҜҒд»Јз Ғзҡ„йҖ»иҫ‘жҖ§пјҢеҜ№йғЁеҲҶеңәжҷҜйңҖиҰҒз”ЁйӣҶжҲҗжөӢиҜ•е®ҢжҲҗпјҢеҢ…жӢ¬еҠҹиғҪжҖ§жөӢиҜ•гҖҒејӮеёёжөӢиҜ•е’ҢеңәжҷҜеӣһеҪ’гҖӮ

5гҖҒSDNиҝҗз»ҙдҪ“зі»жһ¶жһ„

иҮӘеҠЁеҢ–иҝҗз»ҙжһ¶жһ„дҪ“зі»пјҢеүҚйқўе·Із»ҸжҸҗеҲ°дәҶеҫҲеӨҡеҶ…е®№дәҶеңЁиҝҷйҮҢеҒҡд»Ҙжһ¶жһ„жҰӮи§ҲеҒҡдёӢжҖ»з»“гҖӮ

зӣ®еүҚд»ҺSDNзі»з»ҹжқҘи®Ід»ҺжңҖеә•еұӮзҡ„иө„жәҗпјҢзҪ‘з»ңи®ҫеӨҮгҖҒиҪ¬еҸ‘зҪ‘е…ғгҖҒи®ҫеӨҮгҖҒжңҚеҠЎеҷЁпјҢйҮҮйӣҶйғЁеҲҶејҖе§ӢпјҢдё»иҰҒж¶өзӣ– SNMP зҡ„йҮҮйӣҶпјҢеҜ№дј з»ҹи®ҫеӨҮ Netconf е‘Ҫд»ӨдёӢеҸ‘пјҢеҜ№ж–°и®ҫеӨҮ Openflow зҡ„еҚҸи®®пјҢеҜ№CLIзҡ„з®ЎзҗҶгҖӮ

дёӯй—ҙзҡ„еӯҳеӮЁжҳҜзӢ¬з«ӢеҲҶејҖзҡ„пјҢдёӯй—ҙжңүж—Ҙеҝ—гҖҒй…ҚзҪ®еә“гҖҒзҹҘиҜҶеә“пјҢеңЁеӯҳеӮЁйғЁеҲҶзӢ¬з«ӢеҲҶејҖгҖӮеҠҹиғҪж–№йқўеҢ…жӢ¬зӣ‘жҺ§е‘ҠиӯҰе’Ңж•°жҚ®йҮҮйӣҶпјҢж•°жҚ®еҲҶжһҗе’Ңз»ҹи®ЎпјҢжөҒзЁӢз®ЎзҗҶе’ҢйЎ№зӣ®з®ЎзҗҶпјҢжңүеҫҲеӨ§дёҖйғЁеҲҶжҳҜиө„жәҗз®ЎзҗҶпјҢиө„жәҗз®ЎзҗҶеҢ…жӢ¬ж–ҮжЎЈй…ҚзҪ®пјҢиҝҷйғЁеҲҶдё»иҰҒеҹәдәҺCMDBпјҢеҠҹиғҪйқһеёёејәеӨ§пјҢеҰӮдҪ•з»“еҗҲSDNзі»з»ҹз”Ёиө·жқҘпјҢиҰҒж №жҚ®иҮӘе·ұзҪ‘з»ңеә•еұӮе’ҢжҺ§еҲ¶еҷЁејҖеҸ‘еҒҡеҲ¶е®ҡгҖӮ

ж•…йҡңиҮӘж„Ҳе’Ңе…іиҒ”еҲҶжһҗпјҢеҰӮдҪ•и®©е‘ҠиӯҰдҝЎжҒҜеҪўжҲҗе…іиҒ”пјҢеҮәзҺ°10дёӘе‘ҠиӯҰж—¶пјҢиғҪеҗҰеңЁдҪ зҡ„жүӢжңәжҲ–иҖ…йӮ®д»¶дёҠзңӢеҲ°10дёӘе‘ҠиӯҰпјҢзңҹжӯЈжңүз”Ёзҡ„еҸӘжңү1дёӘгҖӮж•…йҡңиҮӘж„Ҳзі»з»ҹжҳҜеңЁе…іиҒ”еҲҶжһҗеҗҺе®һзҺ°зҡ„пјҢеҪ“еҮәзҺ°10дёӘж•…йҡңпјҢеҰӮдҪ•и®©ж•…йҡңиҮӘеҠЁж¶ҲеӨұпјҢдёҚйңҖиҰҒдәәдёәе№Ійў„з®ЎзҗҶпјҢиҝҷжҳҜиҮӘж„Ҳзҡ„еҠҹиғҪгҖӮеҸҰеӨ–йңҖиҰҒжңүе®үе…Ёзӯ–з•ҘиҙҜйҖҡеә•еұӮе’ҢдёҠеұӮгҖӮе‘ҠиӯҰжё йҒ“еҸҜд»ҘеҢ…жӢ¬йӮ®д»¶гҖҒWBEгҖҒеҫ®дҝЎгҖҒCall CenterзӯүгҖӮжңҖдёҠеұӮдёәдёҚеҗҢзҡ„жқғйҷҗз”ЁжҲ·е…ҘеҸЈгҖӮ

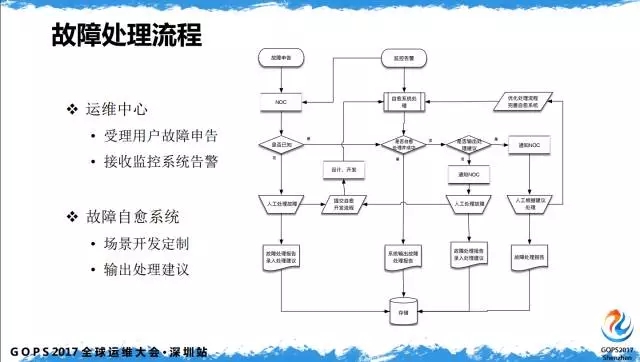

ж•…йҡңеӨ„зҗҶжөҒзЁӢпјҢеңЁеӨ§йғЁеҲҶзҡ„зҪ‘з»ңиҝҗз»ҙйҮҢеҸӘжңү第дёҖйЎ№пјҢиҝҗз»ҙдёӯеҝғеңЁеҒҡзҡ„жҳҜеҸ—зҗҶз”ЁжҲ·ж•…йҡңз”іе‘Ҡд»ҘеҸҠжҺҘ收зӣ‘жҺ§зі»з»ҹе‘ҠиӯҰпјҢиҮӘеҠЁеҢ–иҝҗз»ҙе№іеҸ°жөҒзЁӢйҮҢдјҡеўһеҠ ж•…йҡңиҮӘж„Ҳзі»з»ҹпјҢж №жҚ®еңәжҷҜејҖеҸ‘е®ҡеҲ¶пјҢиҫ“еҮәеӨ„зҗҶе»әи®®гҖӮ

еҪ“дҪ д»ҠеӨ©ж”¶еҲ°з”ЁжҲ·е’Ңзі»з»ҹзҡ„з”іе‘ҠпјҢеҰӮдҪ•и®©е‘ҠиӯҰдёӢдёҖж¬ЎдёҚеҶҚеҮәзҺ°пјҢиҝҷйңҖиҰҒжҲ‘们е·ҘзЁӢеёҲеҲ¶е®ҡиҝҷж ·зҡ„еңәжҷҜпјҢж №жҚ®еӨ„зҗҶйҖ»иҫ‘еҪўжҲҗй—ӯзҺҜпјҢйҖҗжӯҘзҡ„е®Ңе–„иҮӘеҠЁеҢ–иҝҗз»ҙзі»з»ҹгҖӮ

еҺҹж–ҮжқҘиҮӘеҫ®дҝЎе…¬дј—еҸ·пјҡй«ҳж•Ҳиҝҗз»ҙ

жң¬ж–Үй“ҫжҺҘпјҡhttps://www.yunweipai.com/20736.html

зҪ‘еҸӢиҜ„и®әcomments