导读:从 0 到 1,魅族网络架构经历了四个时代,也部署到异地多机房,并成功服务几千万用户。将全国响应速度控制到 30ms,网络架构改造演进过程中积累的经验和教训?基础网络的监控是每个团队关心问题,看魅族做了哪四大监控优化来解决基础网络可用性问题?

李彬成,网络架构师,魅族移动互联网数据中心网络架构负责人。2007—2010 年就职于中盈优创公司,主要负责运营商骨干网及城域网优化工作;2010—2015 年就职于深圳腾讯公司,负责数据中心网络相关工作;2015 年 4 月加入魅族,负责移动互联网数据中心网络的规划设计、优化、运营等工作,在高可用的网络架构和实现上有丰富经验。

移动互联网的网络架构背景

2015 年魅族业绩

2015 年 12 月 21 日魅族副总裁李楠在年度媒体沟通会公布 2015 年总销量突破 2000 万台,同比去年增长 350%,增长率全球手机品牌第一;

2015 年 12 月 29 日魅族副总裁杨颜公布,2015 年魅族 Flyme 注册用户数突破 3000 万,应用商店现有超过 100 万款应用,总下载量超过 100 亿,营收能力同比增长 12 倍。

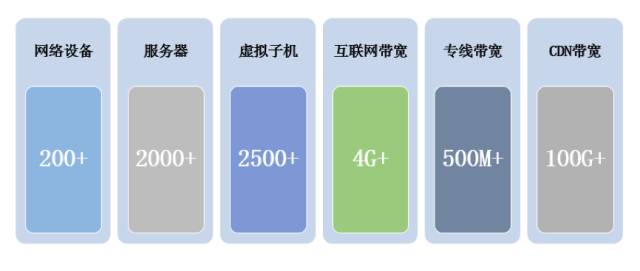

在业绩出现爆发式增长的同时,数据中心基础资源也出现大规模扩张,目前的一些数据如下。

全国低于30ms响应速度:千万级魅族用户的异地多点网络架构如何优化

- 网络设备数量:200+

- 服务器数量:2000+

- 虚拟子机数量:2500+

- 互联网带宽:4G+

- 专线带宽:400M+

- CND 带宽:100G+

运维问题

在传统手机制造业向互联网方向转型,以及业务爆发式增长,基础网络运维遇到过什么问题、困难呢?

- 架构:网络架构脆弱,故障不定时爆发。比如单点架构:IDC 与办公共用办公网珠海总部节点为中心,当中心节点需维护或故障时,将影响 IDC 节点可用性;

- 硬件:硬件性能瓶颈,高峰期 CPU 高达 99%。比如广域网采用低端路由器跑公网 DMVPN,采用 CPU 进行封装、转发,耗设备设能,在晚上高峰期 CPU 经常会高达 99%左右,产生丢包影响;

- 监控:监控覆盖率低,故障无法跟踪定位。比如机房内、机房间、公网的质量情况;

- 运营商:运营商复杂,公网质量无法保障。比如公网链路丢包;

数据中心演进的 4 个时代

一、练级阶段(2010-2013)

1、 2010 – 2011:架构:外网 1.5 个机柜;业务:魅族官网、社区;人力:开发兼运维;

2、2011 – 2012:架构:5 个机柜,二层级联、机架式单系统服务器;业务:魅族官网、社区、商城、Flyme 官网;人力:成立业务运维、DBA 运维;

3、2012 – 2013

- 架构:二层 STP 网络架构、IBM 刀箱 + EMC 存储 + VMWARE 虚拟化

- 业务:魅族官网、社区、商城、Flyme 官网、云服务

- 人力:业务运维、DBA 运维

二、英勇黄铜(2013 年):网络架构 V1.0

“英勇黄铜,金字塔的塔基,就是那种挖坑的存在。如果你掉进去了,想爬上来没有一定的实力真心不容易啊!”

伴随着魅族官网、社区、商城、Flyme 官网、云服务的发展,业务驱动诞生了魅族网络架构 V1.0 版本,主要特点:

- 网络架构:传统二层 STP 网络架构,链路资源利用率低、可靠性性低、维护成本大;

- 硬件设备:性能和稳定性不足,核心设备经常会出现 CPU 负载过高导致重启。

典型机房代表:广州亚太 IDC ,已于 2015 年 12 月完成了裁撤。

三、不屈白银(2014 年):网络架构 V2.0

“不屈白银,大多数玩家都处在这个位置当中。”

伴随着应用中心、游戏中心、O2O、大数据、flyme 云服务、魅族云等发展,传统的网络架构已经无法支撑满足,业务驱动诞生了魅族网络架构 V2.0 版本。

主要特点:

1、网络架构:1)引入 10G 万兆大流量区;2)大二层虚拟化网络架构;3)内、外、管理流量混合;

2、硬件设备:引入数据中心级高密交换机,稳定支撑承载互联网业务。典型机房代表:华南 IDC、华东 IDC。

四、荣耀黄金(2015 年):网络架构 V3.0

“联盟里的中端玩家。”

伴随着互联网业务的爆发性发展,传统的“人肉运维模式”已经无法支撑千万级用户,于是标准化驱动诞生了魅族网络架构 V3.0 版本.

什么叫标准化?举个简单例子:商鞅变法前,秦国各地度量衡不统一。为了保证国家的赋税收入,商鞅制造了标准的度量衡器,意义:全国上下有了标准的度量准则,为人们从事经济文化交流活动提供了便利的条件。

我们是怎么做的呢?我们通过架构设计、网络设备选型、IP规划、网络连接规划、网络配置脚本等制订一套标准规范。

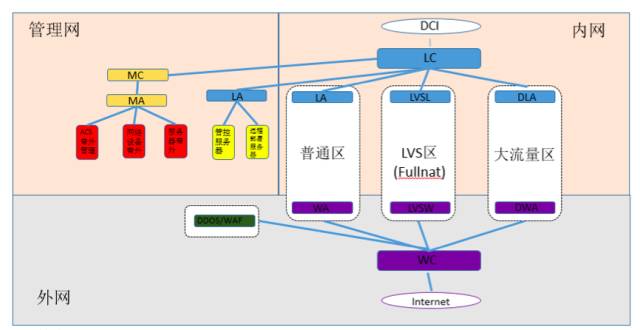

3.0 版本网络架构除标准化外,其它主要特点:

1)三网分离:

a) 结构逻辑清晰;

b) 安全分级:内外网物理隔离,提高内网的安全级别,降低安全风险;

c) 提高网络可用性、吞吐能力;

d) 管理网带外管理,提高运维排错能力。

2)流量可视化:

a) 外网流量特性固定,基本是直上直下的南北流量;

b) 内网流量复杂,属于东西南北穿透。

内外网流量分开便于网络流量管控可视化。

3)单组 TOR 升级:一组 TOR 容量提升 50% 以上。原来 V2.0 一组接入层交换机仅能覆盖 2 个机架(24 台服务器),而 V3.0 版本一组接入层交换机可以覆盖 3 个机架(36 台服务器起)

4)逻辑分区:普通区、LVS 区、大流量区、安全管控区。

5)安全方面:

a) DDOS 流量清洗购买了 BAT 的云盾(腾讯叫宙斯盾)服务;

b) 自研 WAF 平台;

c) 出口 ACL 白名单

V3.0 网络架构版本另外一个突出特点是 LVS 引入了 FULLNAT 模式,逐步淘汰 DR 模式,从而提高了数据中心的扩展性、健壮性。

五、华贵铂金(2016 年后):网络架构 V4.0

测试及进行中,请留意进展。

六、DCI 网络架构介绍

前面所提到的都是单个 IDC 的网络架构,大家都还记得 2013 年 7 月及 2015 年 5 月一些同行的光纤被挖断故障?单机房会存在扩展难、无法容灾、无就近接入等问题。针对单机房问题,我们的应对措施:

- 制定运营商、代理商服务 SLA 协议标准,比如 99.9%;

- 多线 IDC + 分布式数据中心部署,提高业务部署冗余性,提高业务部署冗余性。

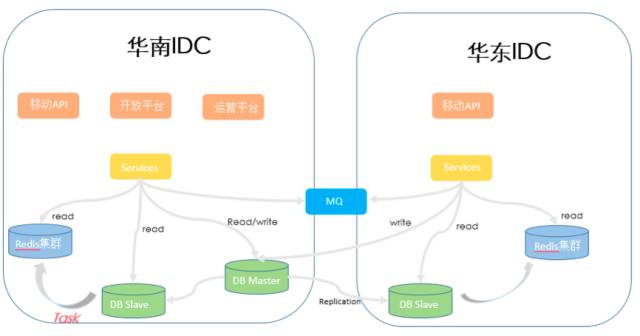

接下来将分享我们的 DCI 网络架构:

先简单概述我们多机房业务的部署,目前我们通过 GSLB 已经实现了用户就近接入,提高了用户体验,即华东片区用户访问华东 IDC,华南片区用户访问华南 IDC。 关于异地多活的方案,我们正在演练阶段,计划今年将会实现。

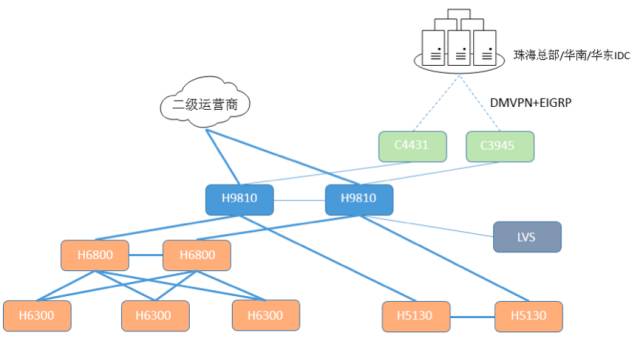

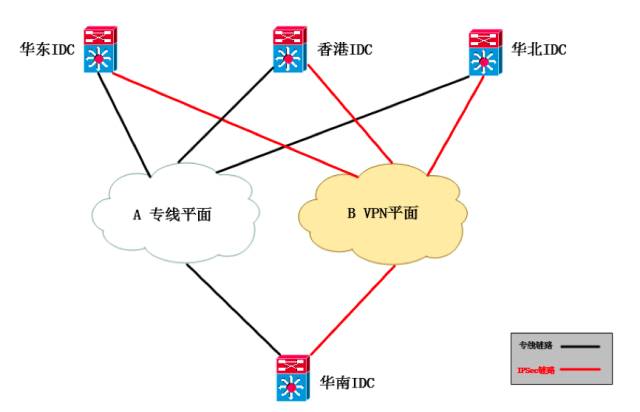

下面看 IDC 基础网络架构,DCI 由专线平面 A 、VPN 平面 B 双平面组成 ,其中专线平面为主,VPN 平面为备,当专线平面瘫痪后,流量会自动切换到 VPN 平面上。

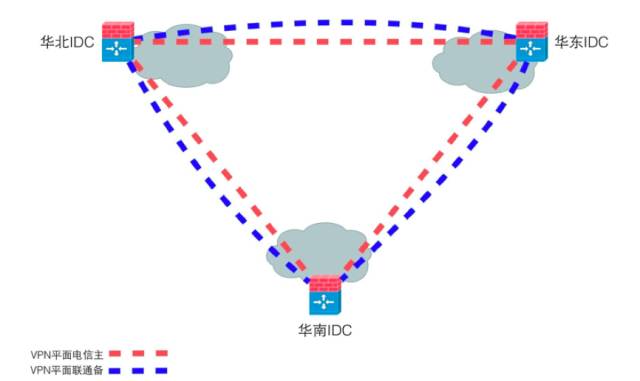

我们先来看看 VPN 平面,节点之间是建立电信、联通链路两条 VPN,路由协议跑的是 IPSEC + EBGP,BGP 具有灵活、稳定的特点,设备选型是 FT 的 1000D,VPN 吞吐量高达 30Gbps 以上,可用性相比 2015 年之前,有了一定的提升。

备注:

99.9%(月中断时长:43.2 分钟)

99.92%(月中断时长:34.56 分钟)

99.95%(月中断时长:21.6 分钟)

我们做过相关的测试:当电信线路发生中断故障,中断 10 – 12S 路由切换到联通链路。

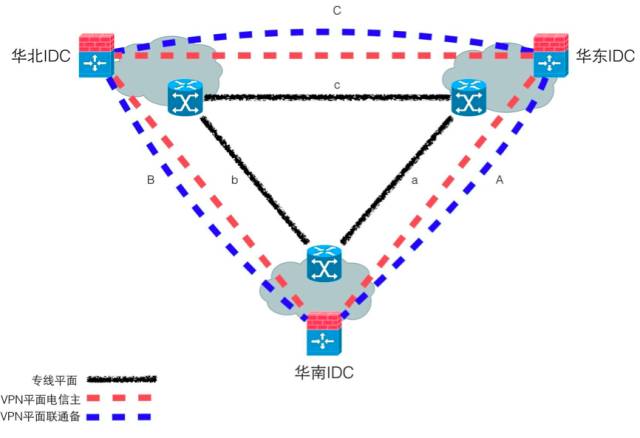

由于运营商网络错综复杂万变,运营商经常凌晨会进行割接或者链路经常出现堵塞,造成广东片区访问北京、华东片区网络丢包等现象,随着互联网业务日益壮大,对网络质量要求越来越高,于是我们在今年 1 月份搭建了专线平面,把可用性提高到至 99.92% – 99.95%,华南、华东、华北互联,构成一个“三角形”环状,当其中一条链路出现故障,流量可以自动切换到第二条链路上。举两个例子:

a)专线平面(A):环保护

比如:华南 ⇒ 华东,当主链路 a 发生异常故障中断,秒级切换至 b,即华南 ⇒ 华北 ⇒ 华东

b)VPN 平面(B):公网冗余保护

比如:华南 ⇒ 华东,当专线同时发生异常故障中断,秒级切换至 B 平面,即华南 ⇒ 华东走 A 链路

七、办公网与 IDC 解耦

数据中心的大概分享到这里,接下来将简单介绍一下办公网以及跟数据中心的互联互访。

曾经踩过的坑:2015 年 7 月珠海总部办公大楼掉电,影响中断华南 IDC—华东 IDC 机房间网络的通讯。

办公网与 IDC 解耦,IDC ⇒ FW ⇒ OA:通过 OA 边界墙实现办公网与 IDC 的隔离,默认只放通运维相关的端口,策略申请需要安全部门评估审批。

网络监控的 4 大优化

面对千万级用户的异地多点网络架构,魅族的网络监控是怎么支撑的呢?

监控痛点

我们监控曾经遇到痛点:

- 监控系统可读性差;

- 监控项告警重叠;

- 告警无法定位问题;

- 业务产品带宽使用。

监控架构总体视图

先来看看监控总体视图:

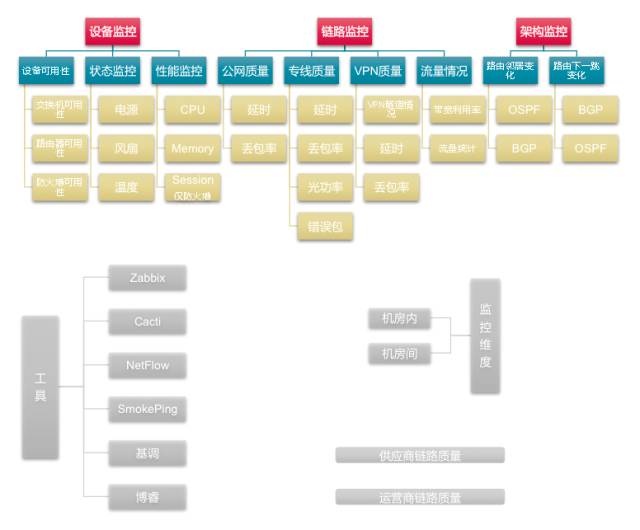

监控对象分三块:

1、设备监控:设备可用性、状态监控、性能监控

2、链路监控:公网质量、专线质量、VPN质量、带宽流量

监控工具主要是:Zabbix、Cacti、Netflow、Smokeping、基调、博睿

一、监控模板标准化的优化

优化前:

监控配置人手一个标准,名称、参数,等一切变量都存在随心而定的情况,导致监控系统的可读性以及准确性存在严重的问题。

优化后:

对设备的监控配置进行了标准化,比如:什么类型的设备用什么样的监控模板,模板需要包含什么内容,甚至是模板的命名也进行了标准化

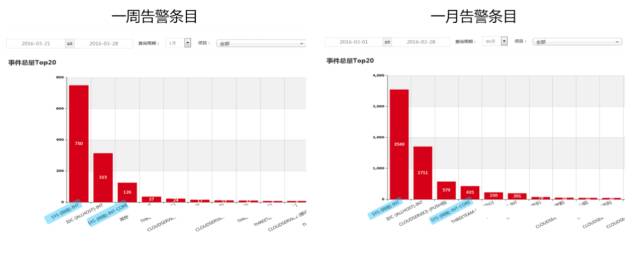

二、告警收敛的优化

优化前:

每日会收到超过 100 条的短信和邮件的告警,很多是一些没有实际意义的告警,严重的干扰了正常的工作,经过对告警信息的分析,主要存在几个问题:1、告警的准确性;2、重复告警;3、通知类告警太多。

优化后:

对告警阀值进行研究,细化,提高告警的准确性,并形成一套告警体系,对重复事件进行关联,通知类事件每天只进行一次邮件通知,极大的优化了监控告警,实现了当收到短信告警时,肯定是发生异常了。

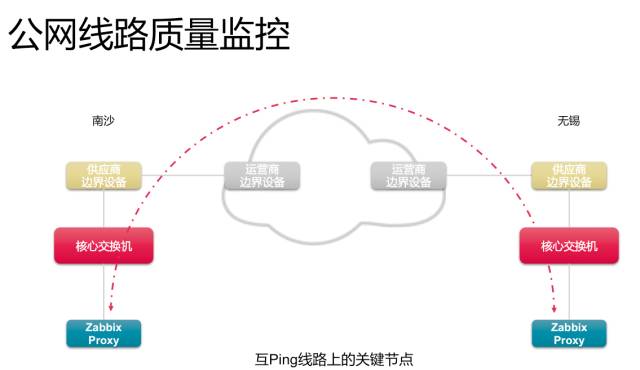

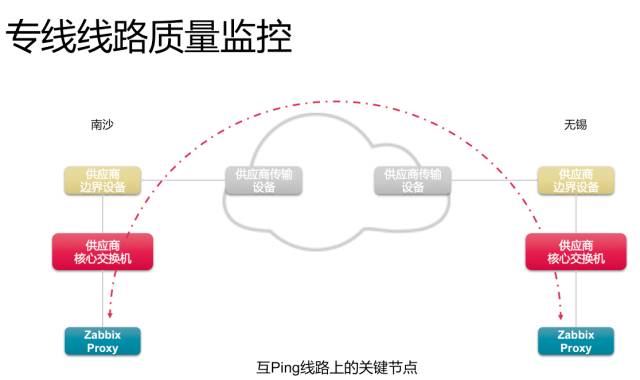

三、公网/专线线路质量监控优化

优化前:

我们 IDC 经过二级运营商接入至一级运营商的网络,专线网络也是同样的情况,当发生故障时,我们只知道整条访问路径有问题,但不知道故障具体发生在哪个节点

优化后:

为了解决这个问题,我们把接入运营商网络时经过的所有关键节点(二级运营商机房的边界、一级运营商网络边界)均纳入到我们的监控系统中,在我们的监控系统中可以非常直观的看到某个运营商整条访问路径的链路质量。

对于专线网络也是同样的做法,我们联合线路供应商,在线路的关键节点上配置了监控地址,整体链路的质量情况也尽在掌握当中。

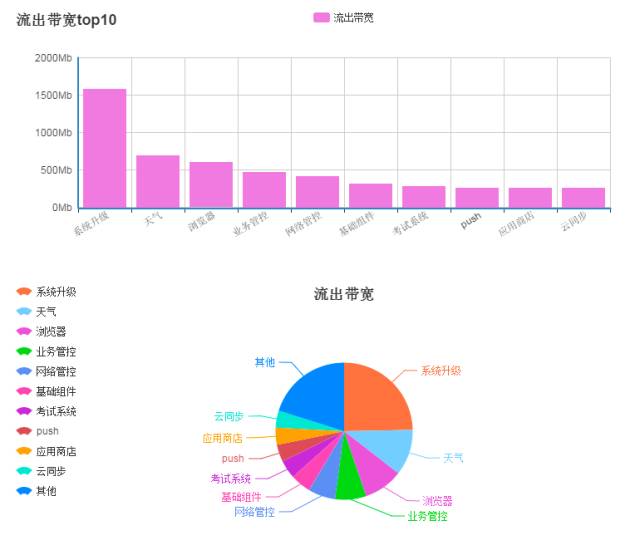

四、带宽可视化的优化

为什么要做这事?主要是基于成本方面考虑,另外对业务的带宽使用情况进行可视化,推动业务优化架构等。

宽容量分配体系可视化,产出带宽产品维度的营收报表,实现按需分配带宽和专线资源,并量化监控。

数据中心的未来

上面提到了网络架构的四个时代,魅族数据中心未来应该如何设计?目前来看有以下几个挑战。

一、多机房 IDC 布署规划

1、国内:分布式

现阶段国内我们在华南、华东、华北均已部署了我们自已的数据中心,从第三方网络质量监测报告显示:覆盖西南、西北片区的用户网络质量较差,延时高达 50-60ms 之间。基于用户访问体验的考虑,将全国用户的响应时间控制在 30ms 以下,是我们优化的目标之一,所以下一阶段我们将会结合业务覆盖用户情况考虑在西南、西北片区部署数据中心节点。

另外一个驱动力是基于业务高可用,下一阶段我们会考虑核心机房同城双活。

2、海外:全球化

国内手机市场利润率逐年降低,国产手机强大后走出国门是必然趋势。业务发展驱动数据中心延伸至海外布局,目前我们海外已完成香港机房布署,下一阶段将会匹配海外业务市场发展情况,进行全球发展部署。

二、SDN + 魅族云

什么叫 SDN?软件定义网络,给我们会带来什么收益?

1、DCI 流量智能调度

现阶段我们 DCI 网络遇到如下挑战:

1)数据中心间网络链路带宽资源有限,难以满足业务临时性的大容量传输需求,对重点业务流量的 QOS 保障需要较长的时间扩容满足,业务部分经常抱怨基础运维侧行动缓慢、缺乏灵活性、响应速度慢。

2)DCI 冗余链路利用率低。

为了更好地满足业务的带宽需求,提升专线利用率及降低运营复杂度,我们下一阶段将会逐步实践 DCI SDN 解决方案

2、云计算网络:

1)租户隔离;2)网络配置自动下发;3)云业务的快速更变;

最后,简单介绍一下我们团队:5 人,主要负责魅族移动互联网数据中心基础网络架构规划、建设、优化、运营等,主要职责如下。

Q&A

问题1:为什么要做标准化网络架构?如何实现?

1、传统的“人肉运维模式”已经无法支撑千万级用户;

2、IDC 网络架构版本设计标准不统一,不利于公司互联网业务快速发展 ;

3、业务的高速增长。

我们的标准化方案:我们通过网络架构规划设计、网络设备选型、全网 IP 规划、网络连接规划、网络配置脚本等制订一套标准规范。

问题2:如何实现办公网与数据中心的互联互访?

我们将办公网与 IDC 解耦,即 IDC ⇒ FW ⇒ OA:消除了过去以珠海总部为集中单一的混合核心节点,通过 OA 边界墙实现办公网与 IDC 的隔离,安全策略默认只放通运维相关的端口,策略申请需要安全部门评估审批。

问题3:为什么要做多机房架构?如何应对单机房、运营商问题?

单机房会存在扩展难、无法容灾、无就近接入等问题。我们的应对措施:1、制定运营商、代理商服务 SLA 协议标准,比如 99.9%;2、多线 IDC + 分布式数据中心部署,提高业务部署冗余性,提高业务部署冗余性。

问题4:异地多点 DCI 网络架构如何保障基础网络的高可用?

我们 DCI 经过半年多的优化整改,已经实现如下效果:DCI 由专线平面 A 、VPN平面 B 双平面组成 ,其中专线平面为主,VPN 平面为备,当专线平面瘫痪后,流量会自动切换到 VPN 平面上。

问题5:网络架构改造演进过程中积累的经验和教训?

1、 架构:网络架构脆弱,故障不定时爆发。比如单点架构:IDC 与办公共用办公网珠海总部节点为中心,办公大楼的基础设施可靠性远不如数据中心,当办公网中心节点需电力等维护或故障时,将影响IDC节点可用性等;

我们的应对措施:网络架构整改,搭建魅族的 DCI 网络、以及推出标准化的 V3.0 网络架构。

2、硬件:硬件性能瓶颈,高峰期 CPU 高达 99%。比如早期的广域网使用低端路由器跑公网 DMVPN,经常会在晚上高峰期 CPU 经常会高达 99% 左右,产生丢包影响;

我们的应对措施:引入数据中心级高密交换机或路由器、防火墙,稳定支撑承载互联网业务。

3、 监控:监控覆盖率低,故障无法跟踪定位。比如机房内、机房间、公网的质量情况等等;

我们的应对措施:1)监控模板标准化;2)告警收敛;3)提高监控覆盖率至99%以上;4)公网/专线线路质量监控;5)带宽可视化。

4、运营商:运营商复杂,公网质量无法保障。比如公网链路丢包等。

我们的应对措施:1、制定运营商、代理商服务 SLA 协议标准,比如 99.9%;2、多线 IDC + 分布式数据中心部署,提高业务部署冗余性,提高业务部署冗余性。

问题6:对公网和 DCI 网络是如何监控的?

1、我们把公网线路和专线线路经过的所有关键节点纳入到监控系统中,实现整条路径的丢包、延时网络质量监测;2、通过基调、博睿等第三方对监控 IDC 至全国各城市的网络质量

问题7:基于什么原因引入 SDN 架构方案?

1、DCI 流量智能调度 ; 2、云平台的租户隔离 ;3、网络配置自动下发; 4、云业务的快速更变。

对网络及基础架构感兴趣的读者,欢迎在本文留言,我们将邀请作者对有效评论进行答疑。

本文由李彬成在高可用架构群分享,转播叶青、尹雯玉。

原文来自高可用架构「ArchNotes」微信公众号

高可用架构微信公众号二维码

本文链接:https://www.yunweipai.com/7620.html

网友评论comments