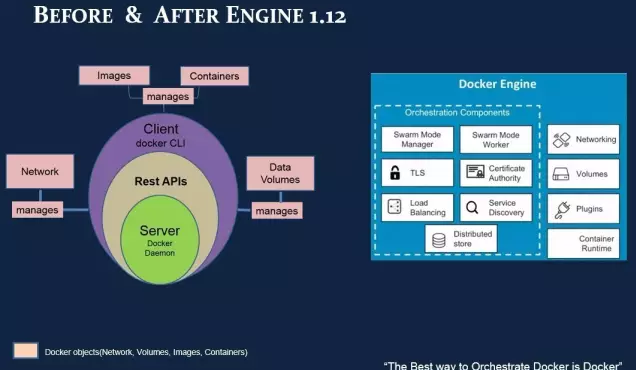

Docker 1.12дёӯе°ҶswarmеҶ…зҪ®еҲ°дәҶDocker EngineдёӯпјҢзҪ‘з»ңйғЁеҲҶд№ҹеҸ‘з”ҹдәҶдёҖдәӣж”№иҝӣпјҢжң¬ж–Үдёӯе°Ҷж·ұе…ҘжҺўи®ЁDocker 1.12дёӯswarmжЁЎејҸдёӢзҡ„зҪ‘з»ңжЁЎеһӢгҖӮ

д»ҘдёӢдёәиҜ‘ж–Үпјҡ

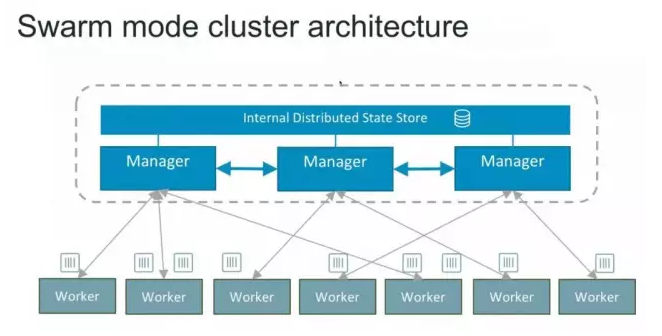

йҰ–е…ҲжқҘдәҶи§ЈдёӢSwarmжЁЎејҸдёӢзҡ„йӣҶзҫӨжһ¶жһ„гҖӮеҰӮдёӢеӣҫжүҖзӨәпјҢиҝҷжҳҜдёҖдёӘе…ёеһӢзҡ„master-slaveзҡ„жһ¶жһ„гҖӮжҜҸдёӘиҠӮзӮ№йғҪжҳҜиҝҗиЎҢзқҖDocker Engineзҡ„Dockerдё»жңәгҖӮдёҖдәӣиҠӮзӮ№жңүжӣҙй«ҳзҡ„жқғйҷҗпјҢиў«з§°дёәManagerгҖӮдёӢйқўз»ҝиүІзҡ„иҠӮзӮ№жҳҜworkerиҠӮзӮ№пјҢжҺҘ收жқҘиҮӘmanagerз»„зҡ„д»»еҠЎжҢҮзӨәгҖӮ

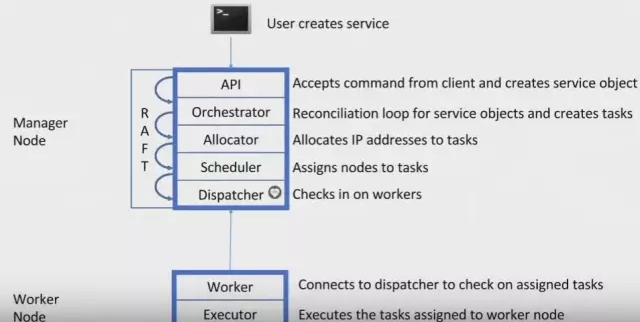

дёӢеӣҫеұ•зӨәдәҶDocker Engineзҡ„swarmжЁЎејҸдёӢиҠӮзӮ№жҳҜеҰӮдҪ•е·ҘдҪңзҡ„пјҡ

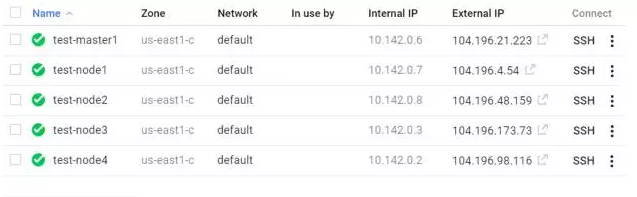

еҰӮдёӢеӣҫжүҖзӨәпјҢжҲ‘еҲӣе»әдәҶдёҖдёӘжңү5дёӘиҠӮзӮ№зҡ„swarmйӣҶзҫӨжөӢиҜ•зҺҜеўғгҖӮ

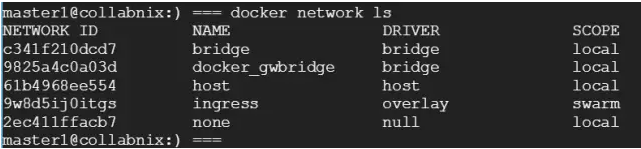

еҰӮжһңSSHеҲ°test-master1зҡ„иҜқпјҢеҸҜд»ҘзңӢеҲ°й»ҳи®Өзҡ„зҪ‘з»ңжӢ“жү‘пјҡ

жҜҸдёӘе®№еҷЁйғҪжңүдёҖдёӘIPең°еқҖпјҢжңүдёүз§Қoverlayзҡ„зҪ‘з»ңжЁЎејҸпјҡ

- Ingress

- docker_gwbridge

- user-defined overlay

еӨ–йғЁз»„件пјҢжҜ”еҰӮдә‘иҙҹиҪҪеқҮиЎЎеҷЁпјҢеҸҜд»Ҙи®ҝй—®йӣҶзҫӨдёӯзҡ„д»»ж„ҸиҠӮзӮ№пјҢдёҚз®ЎиҝҷдёӘиҠӮзӮ№жҳҜеҗҰиҝҗиЎҢзқҖжңҚеҠЎдёӯзҡ„д»»еҠЎгҖӮSwarmйӣҶзҫӨдёӯзҡ„жүҖжңүиҠӮзӮ№йғҪйҖҡиҝҮingressиҝһжҺҘеҲ°иҝҗиЎҢзҡ„д»»еҠЎе®һдҫӢгҖӮеӣ жӯӨпјҢingressйҒөеҫӘиҠӮзӮ№зҪ‘з»ңжЁЎејҸпјҢеҗҢдёҖдёӘжңҚеҠЎеңЁйӣҶзҫӨзҡ„жҜҸдёӘиҠӮзӮ№дёҠйғҪжңүзӣёеҗҢзҡ„з«ҜеҸЈгҖӮ

$docker network create вҖ“subnet={Your prefered subnet } -o com.docker.network.bridge.enable_icc=false -o com.docker.network.bridge.name=docker_gwbridge docker_gwbridge.

зҗҶи®әзҹҘиҜҶд»Ӣз»Қеҫ—е·®дёҚеӨҡдәҶпјҢдёӢйқўжҲ‘们жқҘе®һи·өдёҖдёӢпјҡ

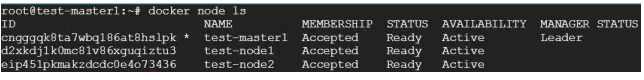

еҰӮдёӢпјҢиҝҷдёӘswarmйӣҶзҫӨдёӯжңү3дёӘиҠӮзӮ№пјҢе…¶дёӯ1дёӘжҳҜmasterиҠӮзӮ№пјҢ2дёӘжҳҜworkerиҠӮзӮ№гҖӮ

йҖҡиҝҮдёӢйқўзҡ„д»Јз ҒеҲӣе»әдәҶдёҖдёӘuser-defined overlayпјҡ

$ sudo docker network create -d overlay mynet

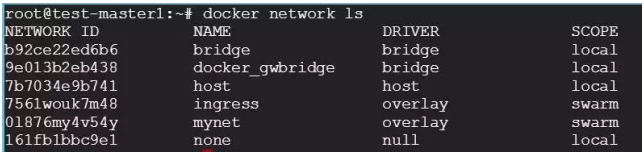

еҸҜд»ҘеңЁswarmжЁЎејҸдёӢзңӢеҲ°ж–°зҡ„overlayзҪ‘з»ңеҲ—иЎЁпјҢеҰӮдёӢпјҡ

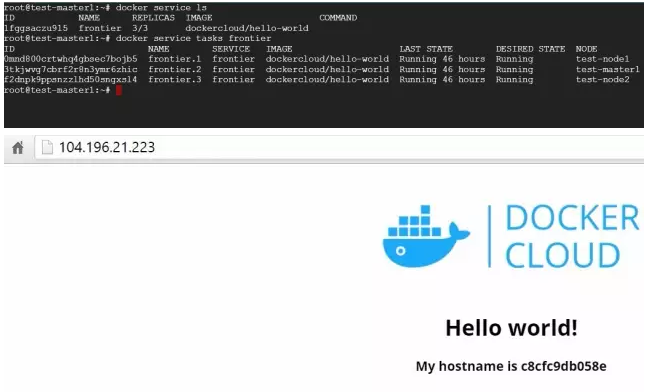

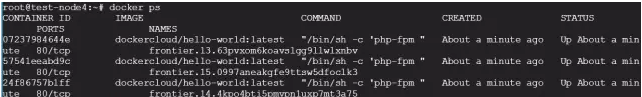

жңүдёҖдёӘеҗҚдёәгҖҺfrontierгҖҸзҡ„жңҚеҠЎпјҢжңҚеҠЎдёӯзҡ„3дёӘд»»еҠЎеҲҶеҲ«иҝҗиЎҢеңЁnode 1пјҢnode 2е’Ңmaster1дёҠпјҢеҰӮдёӢпјҡ

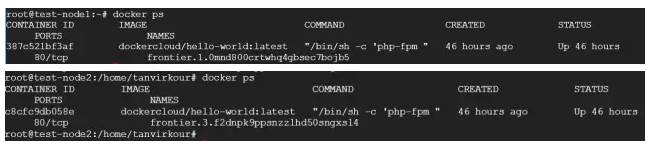

еҸҜд»ҘеҲҶеҲ«жҹҘзңӢеңЁnode-1е’Ңnode-2дёӢзҡ„е®№еҷЁпјҡ

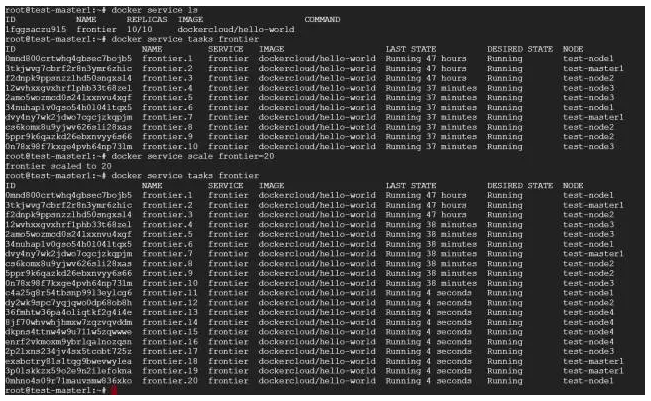

еҗҢж—¶пјҢжҲ‘ж·»еҠ дәҶдёҖдёӘж–°зҡ„Node-3пјҢ并е°Ҷе…¶жү©еұ•еҲ°10дёӘпјҡ

зҺ°еңЁжҲ‘们еҸҜд»ҘзңӢеҲ°иҝҷдәӣе®№еҷЁеңЁswarmйӣҶзҫӨеҶ…иў«жү©еұ•дәҶгҖӮ

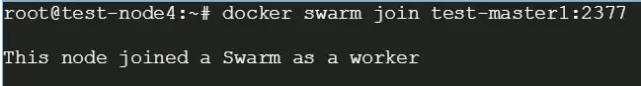

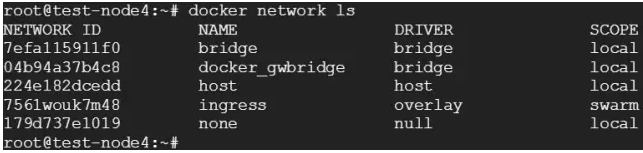

дёәдәҶзңӢдёӢoverlayзҪ‘з»ңжҳҜеҰӮдҪ•е·ҘдҪңзҡ„пјҢжҲ‘们д»Ҙ第4дёӘиҠӮзӮ№дёәзӣ®ж ҮпјҢ并е°Ҷе…¶еҠ еҲ°swarmйӣҶзҫӨдёӯгҖӮ

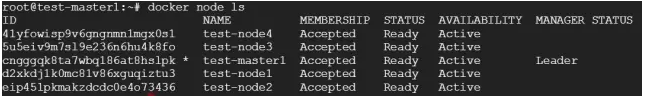

зҺ°еңЁиҠӮзӮ№еҲ—иЎЁжӣҙж–°еҰӮдёӢпјҡ

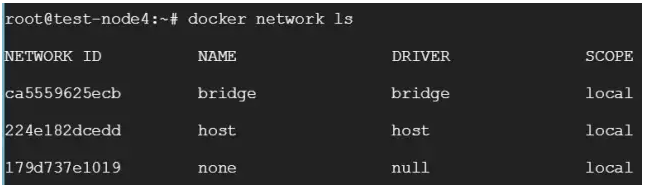

еҗ‘swarmйӣҶзҫӨдёӯж·»еҠ иҠӮзӮ№ж—¶пјҢmynetзҡ„overlayзҪ‘з»ң并дёҚдјҡиҮӘеҠЁжӣҙж–°пјҡ

еҸӘжңүж–°д»»еҠЎиў«еҲҶй…Қж—¶пјҢoverlayзҪ‘з»ңжүҚдјҡиў«еҪұе“ҚпјҢиҖҢдё”жҳҜжҢүйңҖзҡ„гҖӮ

дёӢйқўжҲ‘们жү©еұ•ж—§зҡ„жңҚеҠЎпјҢзңӢдёӢnode-4зҪ‘з»ңеёғеұҖжҳҜеҗҰдјҡиў«mynetзҪ‘з»ңеҪұе“ҚгҖӮд№ӢеүҚжҲ‘们жңү10дёӘеүҜжң¬еңЁиҝҗиЎҢпјҢеҲҶеҲ«иҝҗиЎҢеңЁmaster1пјҢnode1пјҢnode2е’Ңnode4дёҠпјҢдёҖж—ҰжҲ‘们жү©еұ•еҲ°20дёӘе®һдҫӢпјҢswarmйӣҶзҫӨзҡ„engineдјҡи·ЁжүҖжңүиҠӮзӮ№иҝӣиЎҢжү©еұ•пјҡ

зҺ°еңЁnode-4зҡ„зҪ‘з»ңжӢ“жү‘еҰӮдёӢпјҡ

д»ҘпјҢдёҖж—Ұж–°зҡ„д»»еҠЎиў«жҢҮе®ҡз»ҷиҝҷдёӘиҠӮзӮ№пјҢOverlayзҪ‘з»ңе°ұдјҡиў«жҢүйңҖеҲӣе»әгҖӮ

SwarmиҠӮзӮ№жҳҜиҮӘз»„з»ҮпјҲself-organizingпјүе’ҢиҮӘдҝ®еӨҚпјҲself-healingпјүзҡ„пјҢд»Җд№Ҳж„ҸжҖқпјҹеҸӘиҰҒжңүиҠӮзӮ№жҲ–е®№еҷЁе®•жҺүпјҢswarm engineе°ұдјҡе°қиҜ•дҝ®еӨҚпјҢдёӢйқўжҲ‘们жқҘе…·дҪ“зңӢдёҖдёӢгҖӮ

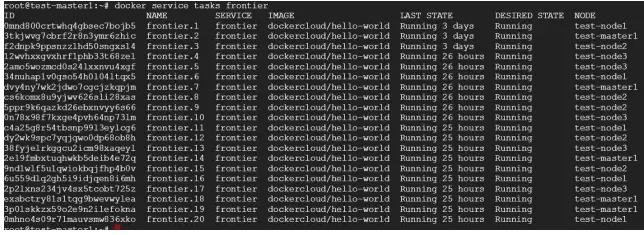

з»ҸиҝҮдёҠйқўзҡ„ж“ҚдҪңд№ӢеҗҺпјҢжҲ‘们жңүд»ҘдёӢеҮ дёӘиҠӮзӮ№пјҡ

- Master-1дёҠиҝҗиЎҢзқҖ4дёӘд»»еҠЎпјӣ

- Node-1дёҠиҝҗиЎҢзқҖ4дёӘд»»еҠЎпјӣ

- Node-2дёҠиҝҗиЎҢзқҖ4дёӘд»»еҠЎпјӣ

- Node-3дёҠиҝҗиЎҢзқҖ4дёӘд»»еҠЎпјӣ

- Node-4дёҠиҝҗиЎҢзқҖ4дёӘе®һдҫӢпјӣ

зҺ°еңЁжҲ‘们让node-4дёҠзҡ„е®№еҷЁйғҪе®•жҺүгҖӮ

дёҖж—Ұnode-4дёҠжүҖжңүе®№еҷЁеҒңжӯўпјҢDockerе°ұдјҡиҜ•еӣҫеңЁзӣёеҗҢзҡ„иҠӮзӮ№дёҠеҗҜеҠЁ4дёӘдёҚеҗҢIDзҡ„е®№еҷЁгҖӮ

иҝҷе°ұжҳҜDocker Swarm Engineзҡ„self-healingеҠҹиғҪгҖӮ

зҺ°еңЁжҲ‘们让node-4ж•ҙдёӘе®•жҺүпјҢnode-4дёҠзҡ„е®№еҷЁдјҡиҮӘеҠЁеңЁе…¶е®ғиҠӮзӮ№дёҠеҗҜеҠЁгҖӮ

- Master-1дёҠиҝҗиЎҢзқҖ5дёӘд»»еҠЎпјӣ

- Node-1дёҠиҝҗиЎҢзқҖ5дёӘд»»еҠЎпјӣ

- Node-2дёҠиҝҗиЎҢзқҖ5дёӘд»»еҠЎпјӣ

- Node-3дёҠиҝҗиЎҢзқҖ4дёӘд»»еҠЎпјӣ

DockerиҮӘеҠЁе°ҶеҺҹnode-4дёҠзҡ„е®№еҷЁеҲҶй…Қз»ҷдәҶе…¶е®ғиҠӮзӮ№гҖӮ

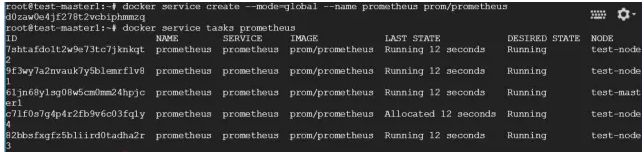

иҝҷдёӘйҖүйЎ№и®©жңҚеҠЎеҸҜд»ҘиҝҗиЎҢеңЁжүҖжңүзҡ„иҠӮзӮ№дёҠпјҢдҪ еҸҜд»ҘеңЁеҲӣе»әжңҚеҠЎзҡ„ж—¶еҖҷпјҢеҠ дёҠ-mode-globalзҡ„йҖүйЎ№пјҢејҖеҗҜиҝҷйЎ№еҠҹиғҪпјҡ

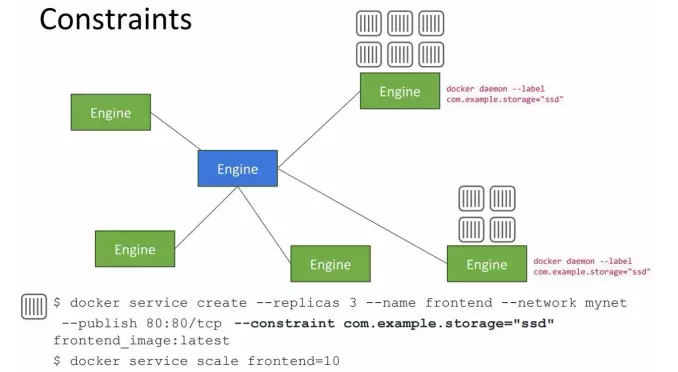

жңүдәӣжғ…еҶөдёӢпјҢдҪ дјҡжғіиҰҒжҹҗдәӣе·ҘдҪңиҙҹиҪҪеҲҶзҰ»еҮәжқҘпјҢиҝҗиЎҢеңЁзү№е®ҡзҡ„иҠӮзӮ№дёҠгҖӮжҜ”еҰӮеңЁDockerConдёҠзҡ„жј”и®ІдёӯпјҢеұ•зӨәдәҶcontraintsзҡ„з”Ёжі•пјҡ

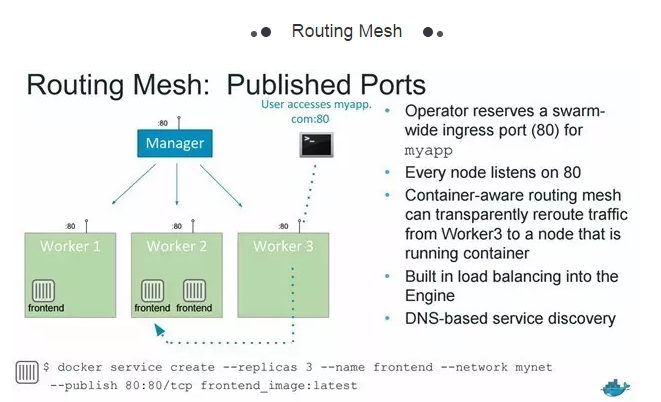

еҒҮи®ҫеңЁmyapp:80жңҚеҠЎдёҠпјҢжңү1дёӘmanagerиҠӮзӮ№е’Ң3дёӘworkerиҠӮзӮ№гҖӮеҪ“жңүдәәжғіиҰҒйҖҡиҝҮжҡҙйңІзҡ„з«ҜеҸЈи®ҝй—®myapp:80зҡ„ж—¶еҖҷпјҢиҝҗж°”еҘҪзҡ„иҜқпјҢдјҡиў«еӨ–йғЁзҡ„иҙҹиҪҪеқҮиЎЎеҷЁеј•жөҒеҲ°worker-2пјҢеӣ дёәworker-2жңү2дёӘеүҚз«Ҝе®№еҷЁзҡ„еүҜжң¬пјҢйҡҸж—¶йғҪеҸҜд»ҘжҸҗдҫӣжңҚеҠЎпјӣдҪҶеҰӮжһңдёҚе№ёи®ҝй—®myapp:80зҡ„иҜ·жұӮпјҢиў«йҮҚе®ҡеҗ‘еҲ°дәҶжІЎжңүе®№еҷЁеүҜжң¬зҡ„worker-3пјҢе°ұжҳҜRouting MeshжҠҖжңҜеҸ‘жҢҘдҪңз”Ёзҡ„ж—¶еҖҷдәҶгҖӮworker-3дёҠжІЎжңүе®№еҷЁзҡ„еүҜжң¬пјҢDocker Swarm Engineе°ұдјҡе°ҶжөҒйҮҸйҮҚж–°и·Ҝз”ұеҲ°жңүи¶іеӨҹеүҜжң¬зҡ„worker-2дёҠжҸҗдҫӣжңҚеҠЎгҖӮеӨ–йғЁзҡ„иҙҹиҪҪеқҮиЎЎеҷЁдёҚйңҖиҰҒзҹҘйҒ“е®№еҷЁеңЁе“ӘйҮҢиҝҗиЎҢгҖӮRouting MeshжҳҜиҮӘеҠЁе®ҢжҲҗиҝҷдёҖзі»еҲ—еҠЁдҪңзҡ„гҖӮ

жҖ»д№ӢпјҢе®№еҷЁж„ҹзҹҘзҡ„Routing Meshе°ұжҳҜе°ҶжөҒйҮҸд»Һnode-3йҮҚж–°и·Ҝз”ұеҲ°иҝҗиЎҢзқҖе®№еҷЁзҡ„node-2гҖӮDocker EngineеңЁйӣҶзҫӨеҶ…йғЁеҲҶй…Қз«ҜеҸЈпјҢ并е°Ҷз«ҜеҸЈеҜ№еә”еҲ°жңҚеҠЎзҡ„е®№еҷЁпјҢRouting MeshдјҡйҖҡиҝҮдёәswarmдёӯжҜҸдёӘиҠӮзӮ№жҡҙйңІдёҖдёӘз«ҜеҸЈпјҢжқҘдҝқиҜҒжөҒйҮҸиў«еј•еҲ°жӯЈзЎ®зҡ„е®№еҷЁдёҠгҖӮ

еҺҹж–Үй“ҫжҺҘпјҡhttp://collabnix.com/archives/1391

е‘Ёе°Ҹз’җВ иҜ‘

еҺҹж–ҮеҮәеӨ„пјҡзҒөйӣҖдә‘

жң¬ж–Үй“ҫжҺҘпјҡhttps://www.yunweipai.com/8185.html

зҪ‘еҸӢиҜ„и®әcomments