Shell脚本编程的”十八般武艺”:提升运维效率的高级技巧

引言:从一次”3秒优化到0.3秒”说起

记得去年双十一前夕,我们的日志分析脚本需要处理每天近10TB的数据。原本需要跑3个小时的脚本,通过一个简单的原理——并行处理与管道优化,硬生生压缩到了20分钟。这个经历让我深刻认识到:Shell脚本不仅仅是”胶水语言”,掌握其高级特性,它就是运维工程师手中的”瑞士军刀”。

今天,我想和大家分享那些年踩过的坑、总结的技巧,以及那些让人拍案叫绝的Shell”黑魔法”。

一、为什么Shell脚本依然是运维的”主力军”?

在容器化、云原生大行其道的今天,你可能会问:还有必要深入学习Shell吗?

我的答案是:绝对有必要!

想象一下这些场景:

- • 凌晨3点,生产环境告警,你需要快速定位问题

- • Kubernetes Pod启动失败,需要批量检查数百个节点

- • CI/CD流水线需要自定义复杂的部署逻辑

- • 数据库备份脚本需要智能判断并执行不同策略

这些场景下,Shell脚本就像是医生的听诊器——简单、直接、高效。更重要的是,它无需额外部署,在任何Linux环境下都能立即使用。

二、Shell脚本的”十八般武艺”实战精华

武艺一:并行处理的艺术

先看一个真实案例。我们需要检查1000台服务器的磁盘使用率:

#!/bin/bash

# 传统方式:串行执行,耗时约500秒

for host in $(cat servers.txt); do

ssh $host "df -h" >> result.txt

done

# 高级技巧:使用并行处理,耗时约10秒

check_disk() {

local host=$1

ssh -o ConnectTimeout=5 $host "df -h" 2>/dev/null || echo "$host: 连接失败"

}

export -f check_disk

# 使用GNU parallel或xargs实现并行

cat servers.txt | xargs -P 50 -I {} bash -c 'check_disk {}'

# 更优雅的方式:使用进程池控制并发数

MAX_JOBS=50

job_count=0

while IFS= read -r host; do

check_disk "$host" &

((job_count++))

if [ $job_count -ge $MAX_JOBS ]; then

wait -n # 等待任意一个后台任务完成

((job_count--))

fi

done < servers.txt

wait # 等待所有剩余任务完成

关键点:并行不是越多越好,需要根据网络带宽和目标服务器负载合理设置并发数。

武艺二:错误处理的"防御式编程"

生产环境的脚本必须具备"防弹"能力:

#!/bin/bash

# 设置严格模式

set -euo pipefail

IFS=$'\n\t'

# 自定义错误处理函数

error_exit() {

echo "错误:$1" >&2

# 发送告警(集成到你的监控系统)

curl -X POST https://alert.company.com/webhook \

-d "{\"message\": \"脚本执行失败: $1\"}" \

2>/dev/null

exit 1

}

# 使用trap捕获错误

trap 'error_exit "在第 $LINENO 行发生错误"' ERR

# 智能重试机制

retry_command() {

local max_attempts=${1:-3}

local delay=${2:-1}

local command="${@:3}"

local attempt=1

while [ $attempt -le $max_attempts ]; do

if eval "$command"; then

return 0

fi

echo "命令失败,${delay}秒后重试... (尝试 $attempt/$max_attempts)"

sleep $delay

((attempt++))

delay=$((delay * 2)) # 指数退避

done

return 1

}

# 实际应用

retry_command 3 2 "curl -f https://api.example.com/health" || error_exit "API健康检查失败"

武艺三:性能优化的"终极秘籍"

这是我总结的Shell脚本性能优化清单:

# 1. 避免无用的cat(UUOC - Useless Use of Cat)

# 错误示范

cat file.txt | grep "pattern"

# 正确做法

grep "pattern" file.txt

# 2. 使用内建命令替代外部程序

# 错误示范

result=$(echo "$string" | sed 's/old/new/')

# 正确做法

result=${string//old/new}

# 3. 批量处理而非循环

# 错误示范:逐行处理大文件

while read line; do

echo "$line" | awk '{print $2}'

done < bigfile.txt

# 正确做法:一次性处理

awk '{print $2}' bigfile.txt

# 4. 使用进程替换避免临时文件

# 传统方式

sort file1.txt > tmp1.txt

sort file2.txt > tmp2.txt

diff tmp1.txt tmp2.txt

rm tmp1.txt tmp2.txt

# 高级技巧

diff <(sort file1.txt) <(sort file2.txt)

# 5. 预编译正则表达式

# 对于需要多次使用的复杂正则

regex='^[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}$'

grep -E "$regex" access.log | while read ip; do

# 处理IP地址

done

武艺四:日志分析的"流式处理"

处理海量日志时,流式处理能大幅降低内存占用:

#!/bin/bash

# 实时分析nginx访问日志,统计TOP 10 访问IP

analyze_logs() {

# 使用awk进行流式处理,避免将整个文件载入内存

tail -f /var/log/nginx/access.log | \

awk '

{

# 提取IP地址(第一个字段)

ip_count[$1]++

# 每处理10000行输出一次统计

if (NR % 10000 == 0) {

print "=== 统计时间:", strftime("%Y-%m-%d %H:%M:%S"), "==="

# 排序并输出TOP 10

n = asorti(ip_count, sorted_ips, "@val_num_desc")

for (i = 1; i <= 10 && i <= n; i++) {

print sorted_ips[i], ip_count[sorted_ips[i]]

}

print ""

}

}

'

}

# 配合监控告警

analyze_logs | while read line; do

# 检测异常访问模式

if echo "$line" | grep -q "^[0-9]" && \

[ $(echo "$line" | awk '{print $2}') -gt 1000 ]; then

# 发送告警

echo "检测到高频访问: $line"

fi

done

武艺五:容器环境下的Shell实践

在Kubernetes环境中,Shell脚本扮演着重要角色:

#!/bin/bash

# K8s Pod健康检查脚本

# 1. 批量重启异常Pod

kubectl get pods --all-namespaces | \

grep -E "CrashLoopBackOff|Error|Evicted" | \

awk '{print $1, $2}' | \

while read namespace pod; do

echo "重启Pod: $namespace/$pod"

kubectl delete pod $pod -n $namespace --grace-period=0 --force

done

# 2. 智能扩缩容脚本

auto_scale() {

local deployment=$1

local namespace=${2:-default}

local cpu_threshold=80

# 获取当前CPU使用率

cpu_usage=$(kubectl top pods -n $namespace | \

grep $deployment | \

awk '{sum+=$2} END {print sum/NR}' | \

sed 's/%//')

current_replicas=$(kubectl get deployment $deployment -n $namespace \

-o jsonpath='{.spec.replicas}')

if (( $(echo "$cpu_usage > $cpu_threshold" | bc -l) )); then

# 扩容

new_replicas=$((current_replicas + 2))

kubectl scale deployment $deployment -n $namespace --replicas=$new_replicas

echo "扩容: $deployment 从 $current_replicas 到 $new_replicas 副本"

elif (( $(echo "$cpu_usage < 30" | bc -l) )) && [ $current_replicas -gt 2 ]; then

# 缩容

new_replicas=$((current_replicas - 1))

kubectl scale deployment $deployment -n $namespace --replicas=$new_replicas

echo "缩容: $deployment 从 $current_replicas 到 $new_replicas 副本"

fi

}

# 3. 日志收集与分析

collect_pod_logs() {

local label_selector=$1

local since=${2:-1h}

kubectl get pods -l "$label_selector" -o name | \

parallel -j 10 "kubectl logs {} --since=$since 2>/dev/null | \

grep -E 'ERROR|FATAL|Exception' | \

jq -R -s 'split(\"\n\") | map(select(length > 0))'"

}

三、我的运维"踩坑"经验分享

1. 变量作用域的陷阱

# 错误示例:管道中的变量修改不会影响外部

count=0

cat file.txt | while read line; do

((count++)) # 这个修改在子shell中,不会影响外部的count

done

echo "行数: $count" # 永远输出0

# 正确做法

count=0

while read line; do

((count++))

done < file.txt

echo "行数: $count"

2. 文件名中的空格处理

# 危险操作

for file in $(ls *.txt); do

rm $file # 如果文件名含空格,会出错

done

# 安全做法

for file in *.txt; do

[ -e "$file" ] || continue # 检查文件是否存在

rm "$file" # 使用引号保护

done

# 更安全:使用find

find . -maxdepth 1 -name "*.txt" -type f -print0 | \

xargs -0 -I {} rm "{}"

3. 密码和敏感信息处理

# 永远不要在命令行明文传递密码

# 错误示范

mysql -u root -p123456 -e "show databases"

# 推荐做法

# 1. 使用环境变量

export MYSQL_PWD="123456"

mysql -u root -e "show databases"

# 2. 使用配置文件

cat > ~/.my.cnf <[client]

password=123456 EOF chmod 600 ~/.my.cnf mysql -u root -e "show databases" # 3. 使用密钥管理服务 password=$(vault kv get -field=password secret/mysql) MYSQL_PWD="$password" mysql -u root -e "show databases"

四、Shell脚本的未来:与现代工具的融合

1. 与AI结合的智能运维

#!/bin/bash

# 集成OpenAI API的智能故障诊断脚本

diagnose_issue() {

local error_log=$1

local context=$(tail -n 100 $error_log | head -n 50)

# 调用AI API分析日志

response=$(curl -s -X POST https://api.openai.com/v1/chat/completions \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4",

"messages": [{

"role": "system",

"content": "你是一个运维专家,分析错误日志并提供解决方案"

}, {

"role": "user",

"content": "'"$context"'"

}]

}' | jq -r '.choices[0].message.content')

echo "AI诊断结果: $response"

# 根据AI建议自动执行修复

if echo "$response" | grep -q "内存不足"; then

echo "检测到内存问题,执行清理..."

sync && echo 3 > /proc/sys/vm/drop_caches

fi

}

2. 与监控系统的深度集成

# Prometheus指标推送

push_metrics() {

local job_name="shell_script_metrics"

local instance="$(hostname)"

# 收集系统指标

cpu_usage=$(top -bn1 | grep "Cpu(s)" | awk '{print $2}' | cut -d'%' -f1)

mem_usage=$(free | grep Mem | awk '{print ($3/$2) * 100.0}')

disk_usage=$(df -h / | awk 'NR==2 {print $5}' | sed 's/%//')

# 推送到Prometheus Pushgateway

cat <五、最佳实践清单:打造生产级Shell脚本

基于多年运维经验,我整理了这份清单:

代码质量

- • ✅ 使用shellcheck进行静态检查

- • ✅ 添加详细的注释和使用说明

- • ✅ 使用有意义的变量名和函数名

- • ✅ 模块化设计,函数单一职责

安全性

- • ✅ 永不在脚本中硬编码密码

- • ✅ 使用set -euo pipefail严格模式

- • ✅ 对用户输入进行验证和清理

- • ✅ 使用最小权限原则

可维护性

- • ✅ 版本控制(Git)

- • ✅ 单元测试(bats框架)

- • ✅ 日志记录规范化

- • ✅ 错误信息清晰明确

性能优化

- • ✅ 避免不必要的外部命令调用

- • ✅ 合理使用并行处理

- • ✅ 大文件使用流式处理

- • ✅ 定期性能评估和优化

结语:持续精进的运维之路

Shell脚本就像武侠小说中的内功心法——看似简单,实则博大精深。掌握这些高级技巧,不仅能让你的运维工作事半功倍,更能在关键时刻化险为夷。

记住:优秀的运维工程师不是会写脚本,而是知道什么时候写、怎么写、写到什么程度。

如果你觉得这篇文章对你有帮助,欢迎:

- • 🌟 收藏本文,建立你的运维知识库

- • 💬 留言分享你的Shell脚本技巧或踩坑经历

- • 🔄 转发给需要的朋友,一起提升运维技能

关注我,每周分享一线运维实战经验,让我们一起在运维的道路上精进成长!

作者简介:10年+运维老兵,经历过日PV过亿的系统架构优化,也处理过凌晨3点的P0故障。专注于分享实战经验,让运维工作更简单、更高效。

文末福利

网络监控是保障网络系统和数据安全的重要手段,能够帮助运维人员及时发现并应对各种问题,及时发现并解决,从而确保网络的顺畅运行。

谢谢一路支持,给大家分享6款开源免费的网络监控工具,并准备了对应的资料文档,建议运维工程师收藏(文末一键领取)。

备注:【监控合集】

100%免费领取

一、zabbix

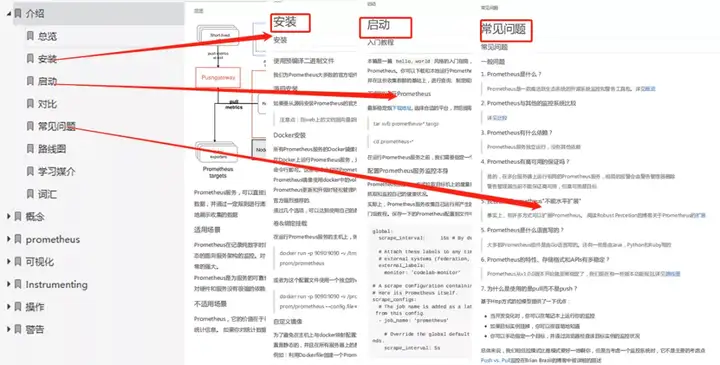

二、Prometheus

内容较多,6款常用网络监控工具(zabbix、Prometheus、Cacti、Grafana、OpenNMS、Nagios)不再一一介绍, 需要的朋友扫码备注【监控合集】,即可100%免费领取。

以上所有资料获取请扫码

备注:【监控合集】

100%免费领取

(后台不再回复,扫码一键领取)

本文链接:https://www.yunweipai.com/47429.html

网友评论comments