дёҖ иғҢжҷҜ

收еҲ°жөӢиҜ•зҺҜеўғйӣҶзҫӨе‘ҠиӯҰпјҢзҷ»йҷҶ K8s йӣҶзҫӨиҝӣиЎҢжҺ’жҹҘгҖӮ

дәҢ ж•…йҡңе®ҡдҪҚ

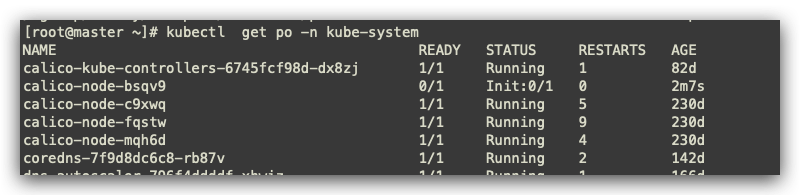

2.1 жҹҘзңӢ Pod

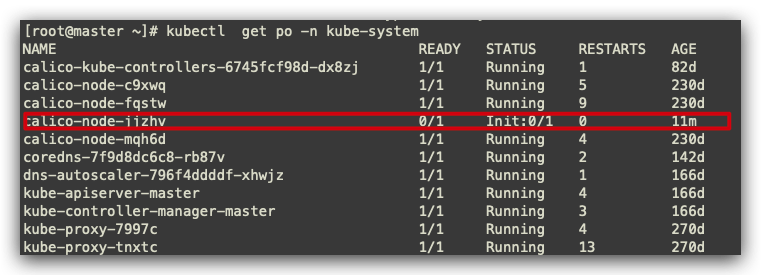

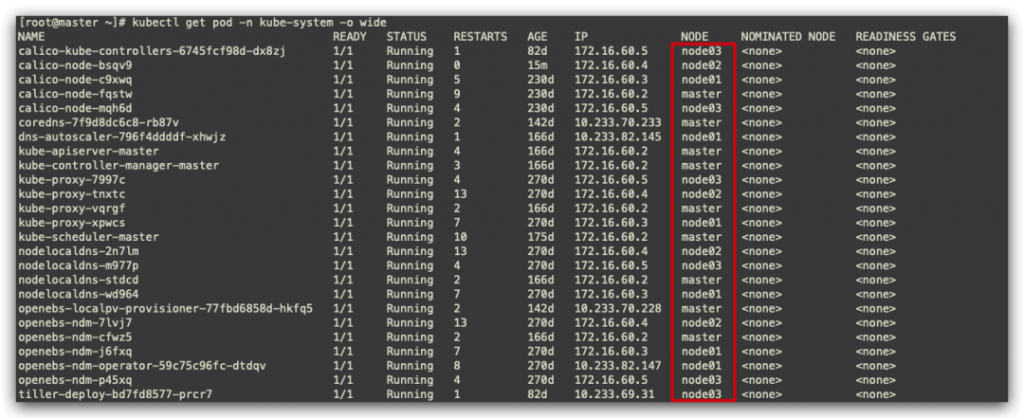

жҹҘзңӢ kube-system node2 иҠӮзӮ№ calico pod ејӮеёёгҖӮ

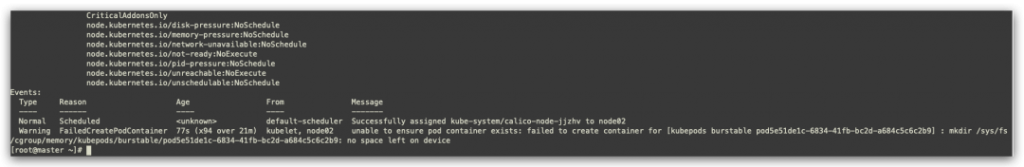

жҹҘзңӢиҜҰз»ҶдҝЎжҒҜпјҢжҹҘзңӢnode2иҠӮзӮ№жІЎжңүеӯҳеӮЁз©әй—ҙпјҢcgroupжі„йңІгҖӮ

2.2 жҹҘзңӢеӯҳеӮЁ

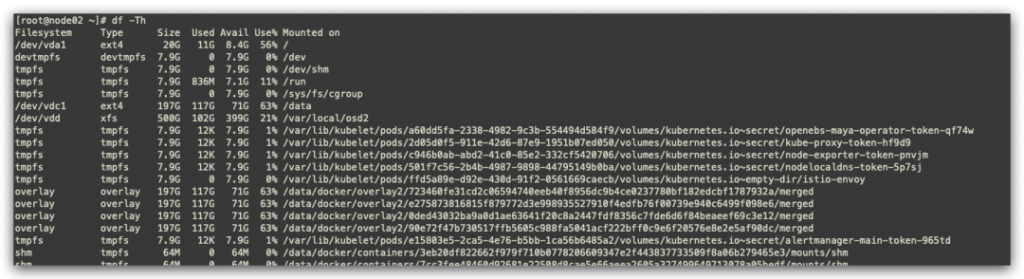

зҷ»йҷҶ node2 жҹҘзңӢжңҚеҠЎеҷЁеӯҳеӮЁдҝЎжҒҜпјҢзӣ®еүҚз©әй—ҙиҝҳеҫҲе……и¶ігҖӮ

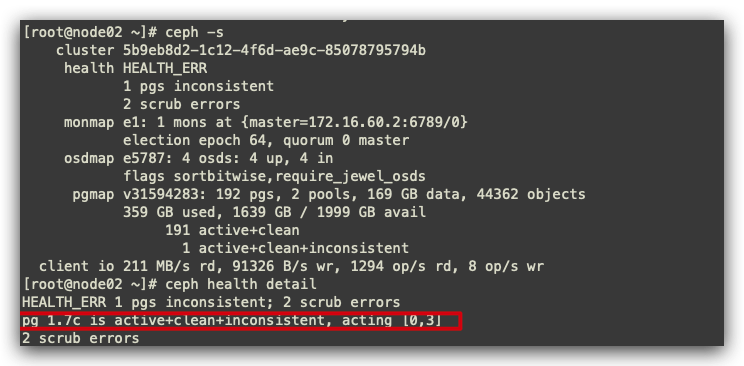

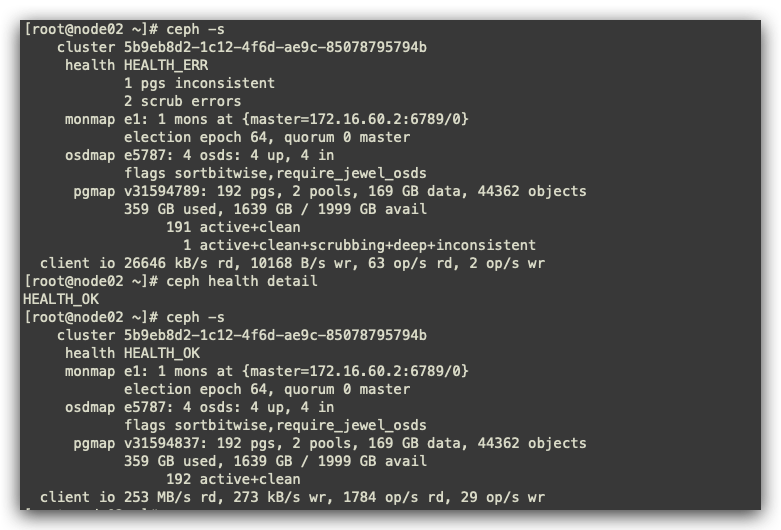

йӣҶзҫӨдҪҝз”ЁеҲ°зҡ„еҲҶеёғејҸеӯҳеӮЁдёәcephпјҢеӣ жӯӨжҹҘзңӢcephйӣҶзҫӨзҠ¶жҖҒгҖӮ

дёү ж“ҚдҪң

3.1 cephдҝ®еӨҚ

зӣ®еүҚжҹҘзңӢеҲ° ceph йӣҶзҫӨејӮеёёпјҢеҸҜиғҪеҜјиҮҙ node2 иҠӮзӮ№ cgroup жі„йңІејӮеёёпјҢиҝӣиЎҢжүӢеҠЁдҝ®еӨҚcephйӣҶзҫӨгҖӮ

ж•°жҚ®зҡ„дёҚдёҖиҮҙжҖ§пјҲinconsistentпјүжҢҮеҜ№иұЎзҡ„еӨ§е°ҸдёҚжӯЈзЎ®гҖҒжҒўеӨҚз»“жқҹеҗҺжҹҗеүҜжң¬еҮәзҺ°дәҶеҜ№иұЎдёўеӨұзҡ„жғ…еҶөгҖӮж•°жҚ®зҡ„дёҚдёҖиҮҙжҖ§дјҡеҜјиҮҙжё…зҗҶеӨұиҙҘпјҲscrub errorпјүгҖӮCEPH еңЁеӯҳеӮЁзҡ„иҝҮзЁӢдёӯпјҢз”ұдәҺзү№ж®ҠеҺҹеӣ пјҢеҸҜиғҪйҒҮеҲ°еҜ№иұЎдҝЎжҒҜеӨ§е°Ҹе’Ңзү©зҗҶзЈҒзӣҳдёҠе®һйҷ…еӨ§е°Ҹж•°жҚ®дёҚдёҖиҮҙзҡ„жғ…еҶөпјҢиҝҷд№ҹдјҡеҜјиҮҙжё…зҗҶеӨұиҙҘгҖӮ

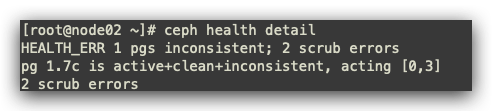

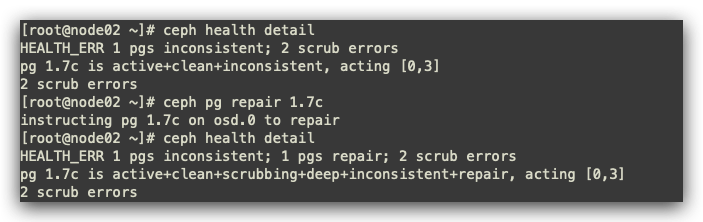

з”ұеӣҫеҸҜзҹҘпјҢpgзј–еҸ·1.7c еӯҳеңЁй—®йўҳпјҢиҝӣиЎҢдҝ®еӨҚгҖӮ

- pgдҝ®еӨҚ

ceph pg repair 1.7c

иҝӣиЎҢдҝ®еӨҚеҗҺпјҢзЁҚзӯүдёҖдјҡпјҢеҶҚж¬ЎиҝӣиЎҢжҹҘзңӢпјҢceph йӣҶзҫӨе·Із»Ҹдҝ®еӨҚ

3.2 иҝӣиЎҢ Pod дҝ®еӨҚ

еҜ№ејӮеёёpodиҝӣиЎҢеҲ йҷӨпјҢз”ұдәҺжңүжҺ§еҲ¶еҷЁпјҢдјҡйҮҚж–°жӢүиө·жңҖж–°зҡ„ PodгҖӮ

жҹҘзңӢ Pod иҝҳжҳҜе’Ңд№ӢеүҚдёҖж ·пјҢеҲҶжһҗеҸҜиғҪз”ұдәҺcephејӮеёёпјҢеҜјиҮҙnode2иҠӮзӮ№cgroupжі„йңІпјҢзҪ‘дёҠжЈҖзҙўйҮҚж–°зј–иҜ‘

Google дёҖз•ӘеҗҺеҸ‘зҺ°еӯҳеңЁзҡ„еҸҜиғҪжңүпјҡ

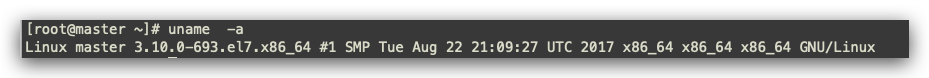

- Kubelet е®ҝдё»жңәзҡ„ Linux еҶ…ж ёиҝҮдҪҺ – Linux version 3.10.0-862.el7.x86_64

- еҸҜд»ҘйҖҡиҝҮзҰҒз”Ёkmemи§ЈеҶі

жҹҘзңӢзі»з»ҹеҶ…ж ёеҚҙжҳҜдҪҺзүҲжң¬

3.3 ж•…йҡңеҶҚж¬Ўе®ҡдҪҚ

жңҖеҗҺпјҢеӣ дёәеңЁеҗҜеҠЁе®№еҷЁзҡ„ж—¶еҖҷ runc зҡ„йҖ»иҫ‘дјҡй»ҳи®Өжү“ејҖе®№еҷЁзҡ„ kmem accountingпјҢеҜјиҮҙ3.10еҶ…ж ёеҸҜиғҪзҡ„жі„жјҸй—®йўҳеңЁжӯӨйңҖиҰҒеҜ№no space leftзҡ„жңҚеҠЎеҷЁиҝӣиЎҢ rebootйҮҚеҗҜпјҢеҚіеҸҜи§ЈеҶій—®йўҳпјҢеҮәзҺ°й—®йўҳзҡ„еҸҜиғҪдёәж®өж—¶й—ҙеҶ…еҲ йҷӨеӨ§йҮҸзҡ„podжүҖиҮҙгҖӮеҲқжӯҘжҖқи·ҜпјҢеҸҜд»ҘеңЁд»ҠеҗҺзҡ„йӣҶзҫӨз®ЎзҗҶжұҮжҖ»пјҢеҜ№жңҚеҠЎеҷЁиҝӣиЎҢз»ҙдҝ®пјҢйҖҡиҝҮеҲ йҷӨиҠӮзӮ№пјҢ并еҜ№иҠӮзӮ№иҝӣиЎҢ reboot еӨ„зҗҶгҖӮ

3.4 еҜ№ node2 иҠӮзӮ№иҝӣиЎҢз»ҙжҠӨ

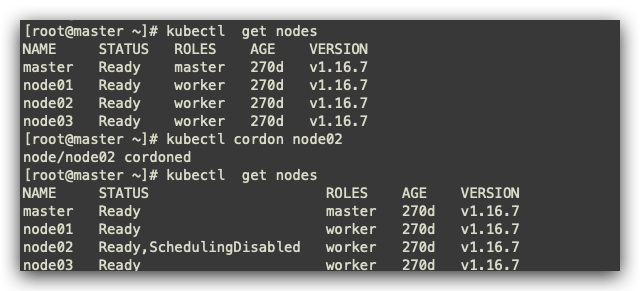

3.4.1 ж Үи®° node2 дёәдёҚеҸҜи°ғеәҰ

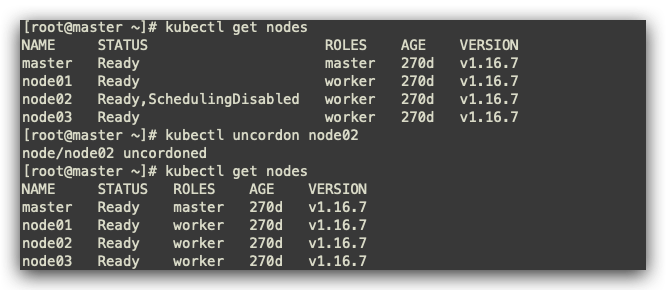

kubectl cordon node02

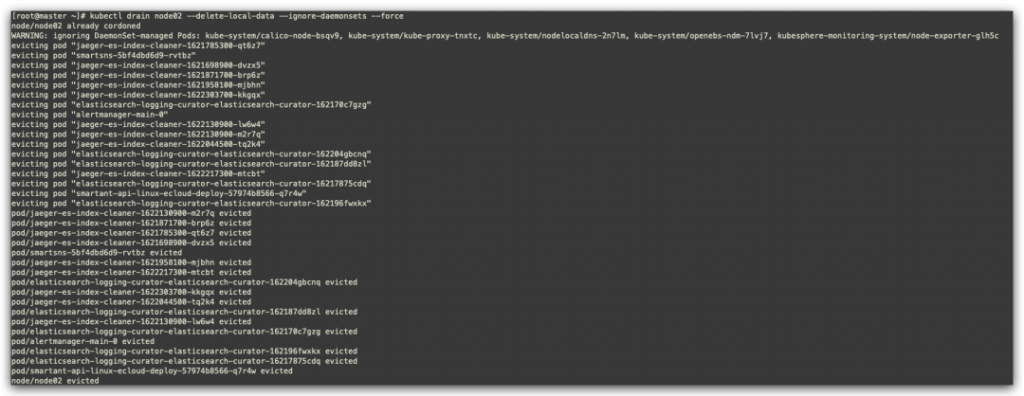

3.4.2 й©ұйҖҗ node2 иҠӮзӮ№дёҠзҡ„ Pod

kubectl drain node02 вҖ”delete-local-data вҖ”ignore-daemonsets вҖ”force- –delete-local-data еҲ йҷӨжң¬ең°ж•°жҚ®пјҢеҚідҪҝemptyDirд№ҹе°ҶеҲ йҷӨпјӣ

- –ignore-daemonsets еҝҪз•Ҙ DeamonSetпјҢеҗҰеҲҷ DeamonSet иў«еҲ йҷӨеҗҺпјҢд»ҚдјҡиҮӘеҠЁйҮҚе»әпјӣ

- –force дёҚеҠ force еҸӮж•°еҸӘдјҡеҲ йҷӨиҜҘ node иҠӮзӮ№дёҠзҡ„ ReplicationControllerпјҢ ReplicaSetпјҢDaemonSetпјҢStatefulSet or JobпјҢеҠ дёҠеҗҺжүҖжңү pod йғҪе°ҶеҲ йҷӨпјӣ

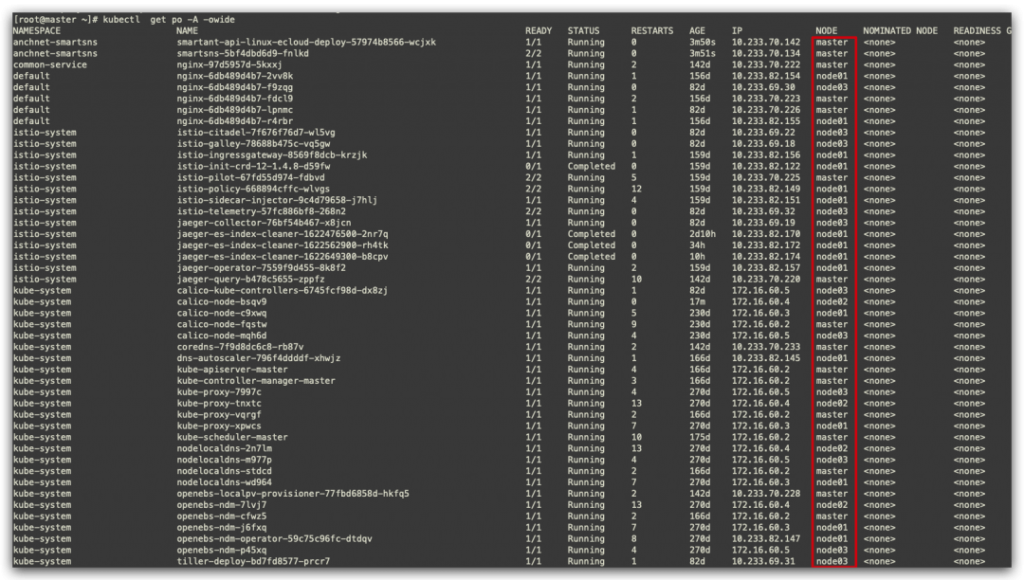

зӣ®еүҚжҹҘзңӢеҹәжң¬ node2 зҡ„ pod еқҮе·Іеү”йҷӨе®ҢжҜ•

жӯӨж—¶дёҺй»ҳи®ӨиҝҒ移дёҚеҗҢзҡ„жҳҜпјҢPod дјҡе…ҲйҮҚе»әеҶҚз»ҲжӯўпјҢжӯӨж—¶зҡ„жңҚеҠЎдёӯж–ӯж—¶й—ҙ=йҮҚе»әж—¶й—ҙ+жңҚеҠЎеҗҜеҠЁж—¶й—ҙ+ readinessжҺўй’ҲжЈҖжөӢжӯЈеёёж—¶й—ҙпјҢеҝ…йЎ»зӯүеҲ°1/1 RunningжңҚеҠЎжүҚдјҡжӯЈеёёгҖӮеӣ жӯӨеңЁеҚ•еүҜжң¬ж—¶иҝҒ移时пјҢжңҚеҠЎз»Ҳз«ҜжҳҜдёҚеҸҜйҒҝе…Қзҡ„гҖӮ

3.4.3 еҜ№ node02 иҝӣиЎҢйҮҚеҗҜ

йҮҚеҗҜеҗҺ node02 е·Із»Ҹдҝ®еӨҚе®ҢжҲҗгҖӮ

еҜ№ node02 иҝӣиЎҢжҒўеӨҚ

- жҒўеӨҚ node02 еҸҜд»ҘжӯЈеёёи°ғеәҰ

kubectl uncordon node02

еӣӣ еҸҚжҖқ

еҗҺжңҹеҸҜд»ҘеҜ№йғЁзҪІ K8s йӣҶзҫӨеҶ…ж ёиҝӣиЎҢеҚҮзә§гҖӮ

йӣҶзҫӨеҶ…еҸҜиғҪ Pod зҡ„ејӮеёёпјҢз”ұдәҺеә•еұӮеӯҳеӮЁжҲ–иҖ…е…¶д»–еҺҹеӣ еҜјиҮҙпјҢйңҖиҰҒе…·дҪ“е®ҡдҪҚеҲ°й—®йўҳиҝӣиЎҢй’ҲеҜ№жҖ§дҝ®еӨҚгҖӮ

еҺҹж–Үй“ҫжҺҘпјҡhttps://juejin.cn/post/6969571897659015205

жң¬ж–Үй“ҫжҺҘпјҡhttps://www.yunweipai.com/42943.html

зҪ‘еҸӢиҜ„и®әcomments