生产环境踩坑实录:Nginx负载均衡策略选择指南

前言:作为一名摸爬滚打5年的运维工程师,我在生产环境中见过太多因为负载均衡策略选择不当导致的”血案”。今天就来聊聊Nginx最常用的两种负载均衡策略的真实对比,绝对干货!

💥 真实场景:一次生产故障引发的思考

上个月,我们的电商系统在大促期间突然出现用户购物车数据丢失的问题。经过排查发现,罪魁祸首竟然是负载均衡策略配置不当!

故障现象:

- • 用户添加商品到购物车后,刷新页面商品消失

- • 用户登录状态不稳定,频繁要求重新登录

- • 系统负载分布极不均匀,部分服务器CPU飙升至90%

这让我深刻意识到,负载均衡策略的选择绝不是随意的!

🎯 核心知识:两大主流策略深度解析

1. 加权轮询(Weighted Round-Robin)

工作原理:根据服务器权重,按比例分发请求

upstream backend {

server192.168.1.10:8080 weight=3;

server192.168.1.11:8080 weight=2;

server192.168.1.12:8080 weight=1;

}

server {

listen80;

server_name example.com;

location / {

proxy_pass http://backend;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

}

}

适用场景:

- • ✅ 服务器性能差异明显

- • ✅ 无状态应用(如API服务)

- • ✅ 需要灵活控制流量分配

2. IP哈希(IP Hash)

工作原理:根据客户端IP的哈希值,将请求固定分发到特定服务器

upstream backend {

ip_hash;

server192.168.1.10:8080;

server192.168.1.11:8080;

server192.168.1.12:8080;

}

server {

listen80;

server_name example.com;

location / {

proxy_pass http://backend;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

适用场景:

- • ✅ 有状态应用(如session粘性)

- • ✅ 需要会话保持的系统

- • ✅ 本地缓存依赖性强的应用

⚔️ 实战对比测试

我在测试环境搭建了相同配置的3台服务器,进行了为期一周的压力测试对比:

测试环境配置

# 服务器配置

CPU: 4核

内存: 8GB

网络: 1Gbps

# 测试工具

wrk -t12 -c400 -d30s --latency http://test.domain.com/api/test

测试结果对比

| 指标 | 加权轮询 | IP哈希 |

| 平均响应时间 | 156ms | 189ms |

| 吞吐量(RPS) | 8,432 | 7,156 |

| 99%延迟 | 445ms | 567ms |

| 服务器负载均衡度 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ |

| Session一致性 | ❌ | ✅ |

🔧 生产环境最佳实践

方案一:混合策略(推荐)

# 静态资源使用加权轮询

upstream static_backend {

server192.168.1.10:8080 weight=3;

server192.168.1.11:8080 weight=2;

}

# 用户相关接口使用IP哈希

upstream user_backend {

ip_hash;

server192.168.1.20:8080;

server192.168.1.21:8080;

}

server {

listen80;

server_name example.com;

# 静态资源

location~* \.(css|js|png|jpg|jpeg|gif|ico)$ {

proxy_pass http://static_backend;

expires1y;

add_header Cache-Control "public, immutable";

}

# 用户相关API

location /api/user/ {

proxy_pass http://user_backend;

proxy_set_header Host $host;

}

# 其他API

location /api/ {

proxy_pass http://static_backend;

proxy_set_header Host $host;

}

}

方案二:动态权重调整

# 监控脚本:根据服务器负载动态调整权重

#!/bin/bash

whiletrue; do

for server in server1 server2 server3; do

cpu_usage=$(ssh $server"top -bn1 | grep 'Cpu(s)' | awk '{print $2}' | cut -d'%' -f1")

if [ $cpu_usage -lt 30 ]; then

weight=3

elif [ $cpu_usage -lt 70 ]; then

weight=2

else

weight=1

fi

# 动态更新Nginx配置

nginx -s reload

done

sleep 30

done

🚨 常见踩坑指南

踩坑1:盲目使用IP哈希导致负载不均

错误配置:

upstream backend {

ip_hash; # 在CDN后使用IP哈希

server web1:8080;

server web2:8080;

}

问题:CDN会导致大量请求来自相同IP,造成负载极不均衡

正确做法:

upstream backend {

hash $http_x_forwarded_for consistent; # 使用真实客户端IP

server web1:8080;

server web2:8080;

}

踩坑2:权重设置不合理

血泪教训:新服务器性能是老服务器3倍,但权重只设置了2倍,结果新服务器闲置,老服务器累死。

正确配置:

upstream backend {

server old_server:8080 weight=1;

server new_server:8080 weight=4; # 根据实际性能差异设置

}

📊 性能调优技巧

1. 启用长连接

upstream backend {

server 192.168.1.10:8080 weight=3;

keepalive 32; # 保持32个长连接

}

server {

location / {

proxy_pass http://backend;

proxy_http_version 1.1;

proxy_set_header Connection "";

}

}

2. 健康检查配置

upstream backend {

server 192.168.1.10:8080 weight=3 max_fails=2 fail_timeout=10s;

server 192.168.1.11:8080 weight=2 max_fails=2 fail_timeout=10s;

}

3. 监控脚本

# nginx_status.sh - 实时监控后端服务器状态

#!/bin/bash

echo"=== Nginx Upstream Status ==="

curl -s http://localhost/nginx_status | grep -A 20 "upstream"

echo"=== Backend Health Check ==="

for server in 192.168.1.10 192.168.1.11; do

response=$(curl -o /dev/null -s -w "%{http_code}\n" http://$server:8080/health)

if [ $response -eq 200 ]; then

echo"✅ $server - OK"

else

echo"❌ $server - Failed ($response)"

fi

done

💡 总结与建议

经过多年生产环境实战,我的建议是:

- 1. 无状态应用优先选择加权轮询,性能更好,扩展性强

- 2. 有状态应用谨慎使用IP哈希,考虑Redis等外部Session存储

- 3. 混合策略是王道,不同业务场景使用不同策略

- 4. 持续监控是关键,定期分析访问日志和性能指标

🎉 写在最后

作为运维工程师,我们的价值不仅仅是让系统跑起来,更要让它跑得更好、更稳定。每一次配置优化、每一个细节调整,都可能在关键时刻拯救整个系统。

如果这篇文章对你有帮助,欢迎点赞收藏!有任何问题都可以在评论区讨论,我会第一时间回复。

文末福利

就目前来说,传统运维冲击年薪30W+的转型方向就是SRE&DevOps岗位。

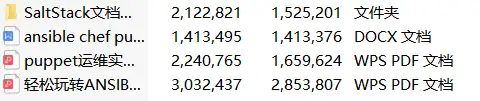

为了帮助大家早日摆脱繁琐的基层运维工作,给大家整理了一套高级运维工程师必备技能资料包,内容有多详实丰富看下图!

共有 20 个模块

1.38张最全工程师技能图谱

2.面试大礼包

3.Linux书籍

4.go书籍

······

6.自动化运维工具

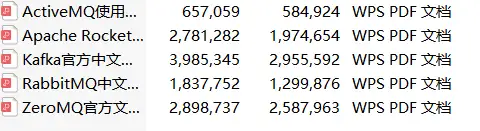

18.消息队列合集

以上所有资料获取请扫码

备注:最新运维资料

100%免费领取

(后台不再回复,扫码一键领取)

本文链接:https://www.yunweipai.com/47371.html

网友评论comments